(2) Netzwerke I & Netzwerktechnik

1. Grundlagen der Datenkommunikation

1.1 Begriffe: Kommunikation und Medium

Kommunikation

Kommunikation ist ein Austausch von Informationen zwischen Quelle (Sender) und Senke (Empfänger) über ein Medium (Träger).

Wir können Kommunikation nach der Informationsart (Sprache, Bild, Daten etc.) und/oder der Übertragungsart (akustisch, optisch, elektromagnetisch) unterscheiden.

Datenkommunikation ist die Übertragung von Information zwischen datenverarbeitenden Systemen (meist Rechner). Dieser Austausch geschieht über Kommunikationssysteme. Für diese braucht man Geräte und Leitungen, aber auch Vereinbarungen (Proto- kolle) und Programme.

Medium

Medium ist der materielle Träger des Informationstransportes.

Jede Kommunikation muss über ein Medium laufen, z.B.:

- Schallwellen für Sprache

- Elektrische Ströme/Spannungen durch einen Draht beim Telefon

- Lichtwellenleiter für Datenaustausch

Die Zuordnung von Information zu den physikalischen Zuständen des Mediums (Strom, Spannung, Lichtstärke, Schwingungen) nennt man Codierung. Die physikalischen Kenngrößen des Mediums sind per se analog. Man kann aber durch Einteilung in Klassen diskrete Codierung erreichen, z.B. für die Spannung:

Spannung > +3V ↔ 1 Spannung < –3V ↔ 0

1.2. Datenübertragung (Unicast, Multicast, Broadcast)

Datenübertragung ist der Austausch von Informationen zwischen Rechnern über ein Medium.

Da Daten auf Rechnersystemen digital vorliegen, erfolgt die Übertragung grundsätzlich digital.

Wird jedoch ein analoges Trägermedium (wie das Telefonnetz) genutzt, spricht man von analoger Übertragung. Hierbei müssen die digitalen Informationen auf den Kanal aufmoduliert werden. Die Geräte, die diese Modulation und Demodulation durchführen, heißen Modems.

Das Wort "Modem" ist eine Kombination aus den Worten "Modulator" und "Demodulator". Aufmodulieren bedeutet, dass der (Sende)Modem das digitale Signal aus Bits in ein analoges Signal für beispielsweise das Telefonnetz (analoges Trägermedium) umwandelt. Der (Empfang)Modem wandelt dann das Signal wieder in ein digitales um.

Der Modem verändert die stetige Welle (das analoge Trägersignal im Telefonnetz) und verändert sie passend zu den Daten, die man senden will.

Dabei können drei Eigenschaften der Welle verändert werden:

- Amplitude (AM): Die Höhe (Stärke) der Welle ändert sich (z. B. hohe Welle = 1, flache Welle = 0).

- Frequenz (FM): Die Schnelligkeit der Welle ändert sich (z. B. schnelle Schwingung = 1, langsame Schwingung = 0).

- Phase (PM): Der Schwingungsansatz verschiebt sich (die Welle macht z. B. einen Sprung).

Unicast (Punkt zu Punkt)

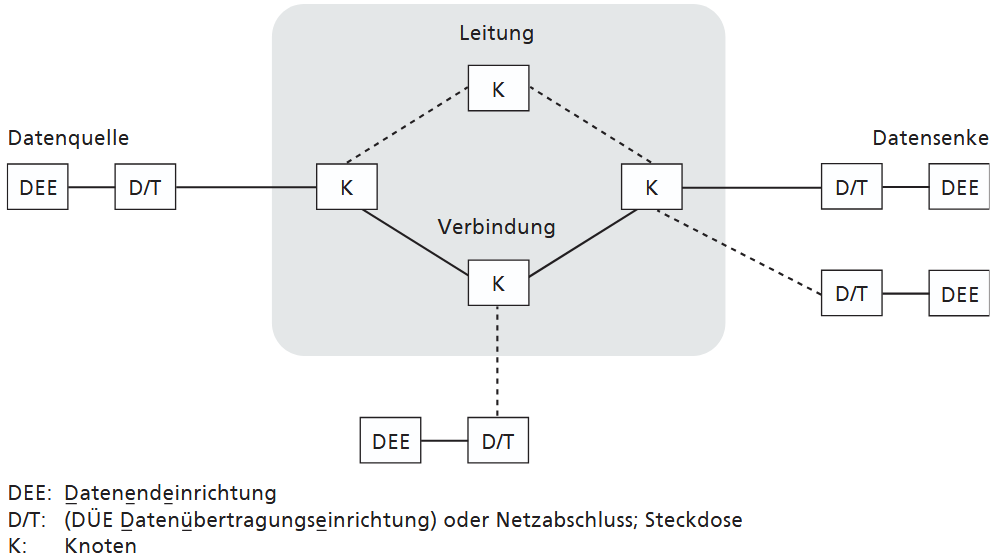

Die Übertragung erfolgt über eine physikalische oder logische Verbindung – Leitung – zwischen zwei Datenendeinrichtungen (DEE).

-

Fest Die Verbindung zwischen den DEE besteht ständig, auch wenn keine Kommunikation ansteht (Umgangssprachlich Standleitung genannt).

-

Vermittelt: Die Verbindung wird durch einen Dienstanbieter (z. B. Telekom) auf Anforderung (Wählen) hergestellt. Die Kommunikation beginnt erst, wenn die Verbindung aufgebaut ist. Zum Ende der Kommunikation wird die Verbindung wieder abgebaut.

Broadcast

Die Kommunikation erfolgt über ein Medium, auf das mehrere Teilnehmer zuhören können Bei menschlicher Kommunikation ist dies sehr oft der Fall (Sprechen in einem Raum), technisch ist dies z. B. von Fernsehen und Radio bekannt. Es gibt aber auch die Möglichkeit, an alle Teilnehmer in Reichweite des Mediums Nachrichten zu verschicken, sogar ohne zu wissen, wer alles mithört (broadcast).

Multicast (Punkt-zu-Mehrpunkt)

Dies ist die Kommunikation von einem Sender an eine ausgewählte Gruppe von Empfängern gleichzeitig. Im Gegensatz zum Broadcast wird hier nicht "blind" an alle gesendet, sondern gezielt an mehrere Teilnehmer. Auch muss die Nachricht nicht für jeden Empfänger einzeln wiederholt werden (kein sequenzielles Verschicken). Das Medium muss allerdings eine gleichzeitige Verbindung zu den gewünschten Teilnehmern unterstützen (z. B. Videokonferenz).

1.3 Kommunikationsnetze

Ein Kommunikationsnetz besteht aus Knoten und Verbindungen zwischen diesen.

Bei einer Datenübertragung können Daten über verschiedene Wege und an mehrere DEE (Datenendeinrichtung) erfolgen. Das Netz enthält Knoten (Informationsweichen), die aufgrund von Steuerinformationen die Daten weiterleiten.

Die logische Verbindung zwischen zwei DEE über die Verbindungsknoten hinweg wird Kanal bezeichnet.

Wenn zu Beginn einer Datenübertragung keine Verbindung aufgebaut wird, nennt man sie verbindungslos. Im Gegensatz dazu nennt man Übertragungsnetze, die Punkt-zu-Punkt-Verbindungen aufbauen (und auch wieder abbauen), verbindungsorientiert. Man hat einen Overhead am Anfang und am Ende, die eigentliche Übertragung kann aber effizienter abgewickelt werden.

Der Overhead ist der zusätzliche Verwaltungsaufwand (Zeit und Datenpakete), der nicht die eigentliche Nachricht enthält, sondern nur dazu dient, die Verbindung am Anfang sicher aufzubauen (z.B. Handshake) und am Ende sauber wieder abzubauen.

1.4 Kommunikationssysteme

Mit Kommunikationssysteme wird der Austausch von Daten organisiert. Dabei gibt es verschiedene Möglichkeiten:

- Zentralisierte Systeme

- Verteilte Systeme

- Client/Server

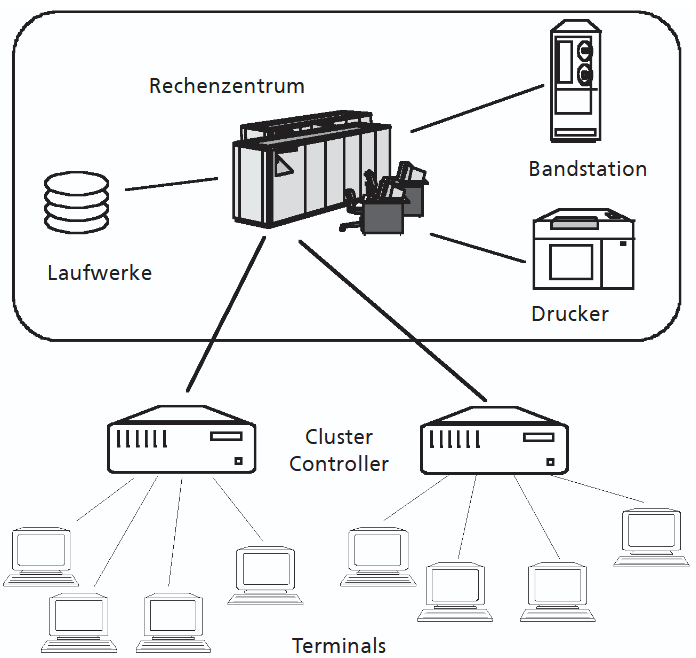

1.4.1. Zentralisierte Systeme

Die Verarbeitung, Speicherung, die wesentlichen Geräte und das Betriebspersonal sind in einem Raum/Gebäude zentralisiert. Räumlich verteilt sind nur einfachere Geräte mit geringem Bedarf an Betreuung. Dies ist die Architektur, die klassisch beim Betrieb von Rechenzentren verwendet wird/wurde.

Die Verbindung der entfernten Einrichtungen zur Zentrale erfolgt über ein sternförmiges oder baumförmiges (hierarchischer Stern) Netz mit Konzentratoren.

1.4.2. Dezentralisierte Systeme

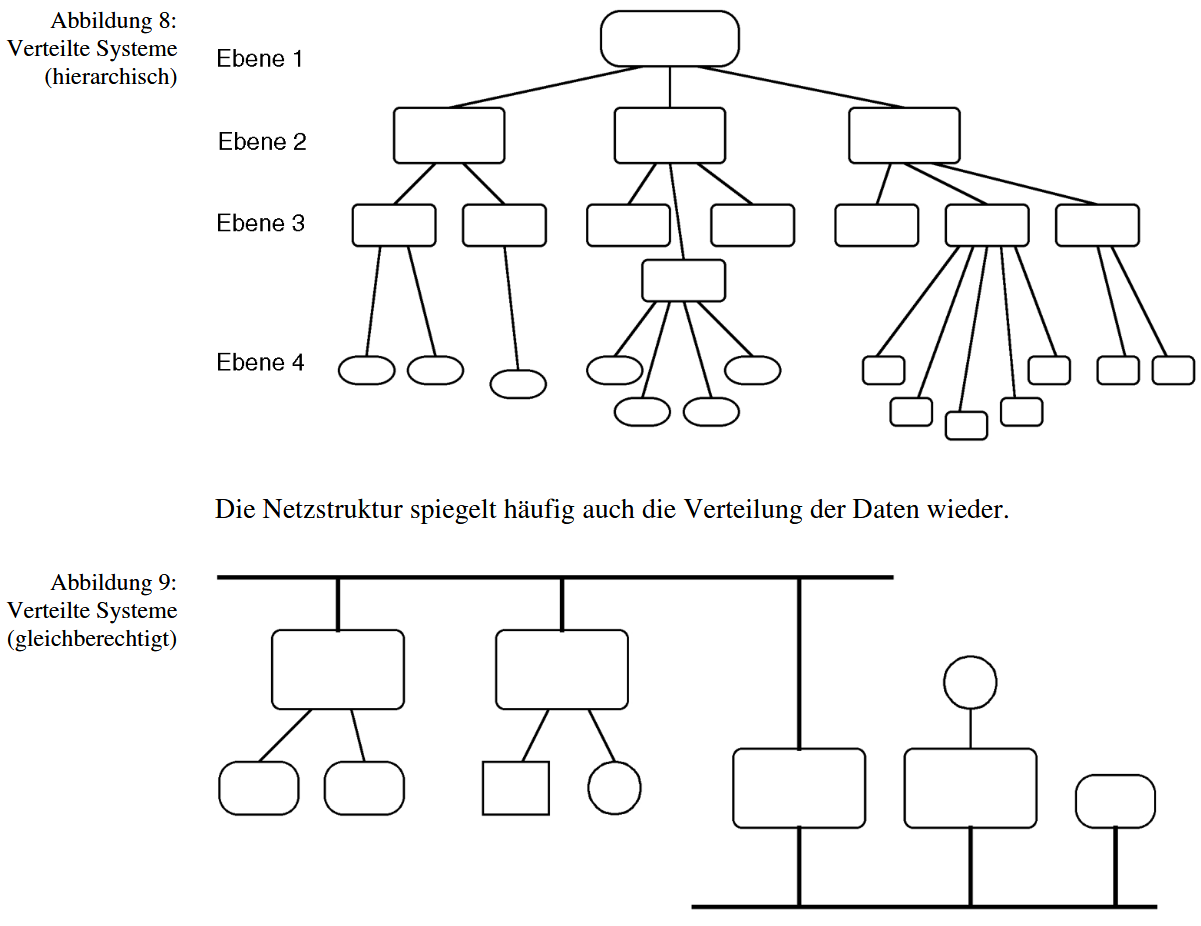

Eine Ansammlung von unabhängigen und geographisch verteilten Einheiten wird als dezentralisierte Systeme bezeichnet. Wenn diese durch ein DÜ-Netz (Datenübertragungsnetz) miteinander verbunden sind und Daten austauschen, wird von einem verteilten System gesprochen.

Ein verteiltes System liegt vor, wenn sich wesentliche Bestandteile an verschiedenen Standorten (sites) befinden und gemeinsam unter gegenseitiger Kommunikation via DÜ-Netz einen Dienst oder mehrere Dienste zur Verfügung stellen.

Es liegt dann mindestens eine der folgenden Situationen vor:

- verteilte Ressourcen bzw. Leistung

- verteilte Datenbestände

- verteilte Funktionalität

Das hierarchische Ebenenkonzept lässt sich am besten am Beispiel der Datenübertragung eines Industriebetriebes veranschaulichen:

- Ebene 1 repräsentiert das Rechenzentrum (Hostrechner),

- Ebene 2 die Leitrechner (z. B. Bereich Fertigung),

- Ebene 3 die Steuerebene (Prozessrechner, z. B. Lagersteuerung) und

- Ebene 4 die Prozessebene (Maschinensteuerung, z. B. Mikroprozessoren).

Bei Systemen mit gleichberechtigten Partnern (Busstruktur) ist jedes lokale System in Hardware und Software den spezifischen Anforderungen angepasst. Die Rechenleistung ist weitgehend lokal verfügbar; nichtlokale (remote) Daten werden extrahiert und aufs lokale System gebracht (download, Datenduplikate) oder es wird direkt übers Netz zugegriffen.

Die Netztopologie ist meist einfach (flach) und nicht hierarchisch aufgebaut. Redundante Datenpfade stehen (oft) zur Verfügung. Lokale Systeme besitzen lokale Autonomie.

Von den anderen verteilten Systemen unterscheiden sie sich dadurch, dass eine akzentuierte Aufgabenverteilung stattfindet. Ein Kommunikationspartner (Server) beheimatet einigermaßen zentral Kernaufgaben wie Datenhaltung, der andere Partner (Client) nutzt aufgabenbezogen Teile des Dienstangebots des Servers und macht noch die nutzerspezifische Aufbereitung. Bei geeigneter Wahl der Schnittstellen können sehr unterschiedliche Systeme auf denselben Server zugreifen. Je nachdem, ob noch eine weitere Dienstschicht zu Hilfe genommen wird, um Client und Server noch besser zu entkop- peln, spricht man auch von 2-Tier oder 3-Tier-Architekturen

1.5 Träger, physikalische Schnittstellen

Jedes Signal brauch einen Träger (Übertragungsmedien). Ein Kanal hat immer eine begrenzte Übertragungskapazität (Bandbreite).

Für unseren Themengebiet sind die diskrete Codierung und diskrete Abtastung relevant. Wie viel Information pro Zeiteinheit (Bit/s) übertragen werden kann hänge nicht nur von den Eingenschaften des Kanals, sondern auch von der Codierung ab.

-

Fourierzerlegung: Das Signal lässt sich mathematisch in eine Summe von einfachen Sinuswellen unterschiedlicher Frequenzen zerlegen. Diese Zerlegung zeigt, aus welchen Frequenzen ein Signal besteht. Das ist wichtig, weil Übertragungskanäle (wie ein Kabel oder Funk) oft nur bestimmte Frequenzen durchlassen

-

Bandbreite (f): Der Frequenzbereich, den ein Kanal übertragen kann. Sie bestimmt das "Tempolimit" der Übertragung.

-

Baud vs. Bit: Baud ist die Anzahl der Signalwechsel pro Sekunde. Bits sind die Informationen pro Sekunde. Durch geschickte Codierung (z. B. 4 Spannungsstufen) kann ein Baud mehrere Bits transportieren.

-

Rauschabstand (S/N): Das Verhältnis von Signal zu Störung. Das Verhältnis von der Stärke des Nutzsignals (S) zum Hintergrundrauschen (N). Rauschen begrenzt die maximale Datenrate physikalisch, weil der Empfänger irgendwann die feinen Signalunterschiede nicht mehr erkennen kann.

Das Shannon-Theorem definiert die maximale Datenübertragungsrate eines Kanals in Abhängigkeit von seiner Bandbreite und dem Signal-Rausch-Verhältnis (S/N). Selbst bei einem ungünstigen Verhältnis, wo das Rauschen überwiegt, ist durch spezielle Verteilungstechniken eine Übertragung möglich, was unter anderem in der Raumfahrt genutzt wird. Diese theoretische Obergrenze ist in der Praxis jedoch technisch anspruchsvoll umzusetzen.

Davon abzugrenzen ist die Digitalisierung analoger Signale: Nach dem Nyquist-Theorem muss die Abtastrate mindestens doppelt so hoch sein wie die höchste zu erfassende Signalfrequenz. So ist die übliche Sprachabtastung von 8 kHz auf die Telefonbandbreite abgestimmt.

1.5.1. Diskrete Datenträger

Diskrete Datenträger speichern Informationen nicht kontinuierlich (wie analoge Schallplatten), sondern in Form von abzählbaren, voneinander getrennten Werten. In der modernen Informatik bedeutet dies meist eine digitale Codierung in Bits (Nullen und Einsen). Diese diskreten Zustände ermöglichen eine fehlerfreie Speicherung und exakte Kopierbarkeit. Beispiele sind Festplatten, SSDs oder USB-Sticks

1.5.2. Draht

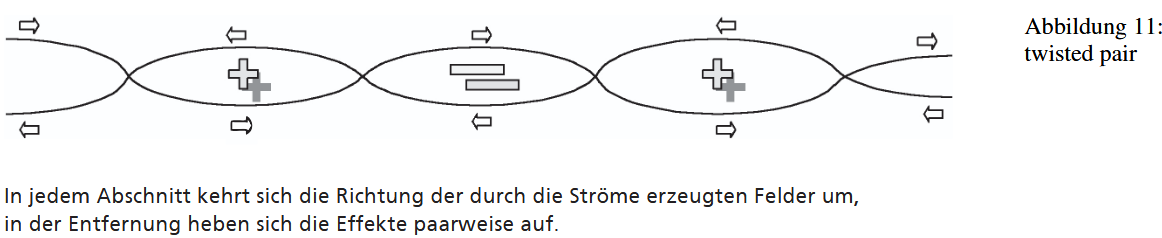

Die älteste und verbreitetste Methode der Datenübertragung nutzt metallische Leiter. Im Gegensatz zu Stromkabeln werden hierbei aufgrund der hohen Frequenzen verdrillte Adernpaare (Twisted Pair) verwendet. Diese Verdrillung unterdrückt effektiv die elektromagnetische Abstrahlung, was die Dämpfung sowie das Übersprechen auf benachbarte Leitungen minimiert und gleichzeitig die Abhörsicherheit erhöht. Eine weitere Verbesserung bietet ein metallischer Schirm, der als Faradayscher Käfig wirkt und elektromagnetische Felder blockiert. Dabei ist sowohl eine Gesamtschirmung des Kabels als auch eine aufwendigere Einzelschirmung der Paare möglich. Diese Maßnahmen schützen das Signal nicht nur vor Abstrahlung, sondern auch vor externen Störeinflüssen wie elektromagnetischen Pulsen. Die Summe dieser Schutzvorkehrungen gegen Sende- und Empfangsstörungen definiert die elektromagnetische Verträglichkeit (EMV).

Was ist Frequenz?

Die Frequenz gibt an, wie oft sich ein periodischer Vorgang (eine Schwingung) innerhalb einer Sekunde wiederholt und es wird in Hertz (Hz) gemessen.

Beispiel: 1 Hz = 1 Schwingung pro Sekunde. 50 Hz = 50 Schwingungen pro Sekunde.

In der Datenübertragung entspricht die Frequenz der Geschwindigkeit der Signaländerung.

- Niedrige Frequenz: Der Signalzustand (z. B. Spannung an/aus) ändert sich langsam.

- Hohe Frequenz: Der Signalzustand ändert sich extrem schnell.

Kupferkabel

Kupferkabel, insbesondere Twisted-Pair (TP)-Kabel, transportieren Strom zur Signalübertragung. Im Unterschied zu Glasfasern, bei denen Lichtzustände direkt als Null oder Eins interpretiert werden, werden bei Kupferkabeln bestimmte Spannungspegel als Bits genutzt. Um diese zuverlässig zu erkennen, wurden verschiedene Codierungsverfahren entwickelt:

-

Einfache Bitcodierung: Null und Eins werden durch zwei Spannungspegel dargestellt. Der Nachteil ist, dass lange Folgen gleicher Bits dazu führen können, dass Sender und Empfänger den Takt verlieren.

-

Manchester-Codierung: Für jedes Bit gibt es einen Spannungswechsel in der Bitmitte. Der erste Teil dient als Taktinformation, der zweite als Dateninhalt. Dadurch ist die Taktrückgewinnung zuverlässig und Fehlinterpretationen werden vermieden.

-

NRZI (Non-Return-to-Zero Inverted): Bei einer Eins wird der Pegel gewechselt, bei Null bleibt er konstant. Lange Nullfolgen werden durch Umwandlung von 4 Bits in 5 Bitfolgen (redundante Kodierung) sicher übertragen.

Twisted-Pair-Kabel bestehen aus einem oder mehreren verdrillten Leitungspaaren. Zwei Paare werden in der Regel benötigt: eins für Senden, eins für Empfangen. Die Verdrillung neutralisiert elektromagnetische Felder, die durch stromführende Adern entstehen, wodurch Störungen minimiert werden.

Kabel können ungeschirmt (Unshielded TP) oder geschirmt (Shielded TP) sein; moderne Varianten verfügen zusätzlich über ein äußeres Metallgeflecht (Foiled TP).

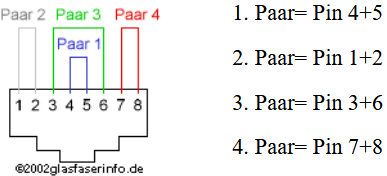

Der Standard DIN EN 50173 regelt die genaue Belegung der vier Kabelpaare einer Steckverbindung hier am Beispiel von Standardethernet:

Jede Kabelader muss mit einem bestimmten Kontakt des Steckers verbunden werden. Im TP-Umfeld hat sich der RJ-45 Stecker als Standard durchgesetzt.

Qualitäts- und Leistungsparameter von Kupferkabeln:

- Wellenwiderstand: Ausdruck der mechanischen Qualität des Kabels.

- Dämpfung: Leistungsverluste bei der Signalübertragung.

- Nebensprechen (Crosstalk): Unerwünschter Signalübertrag auf andere Paare.

- Nahnebensprechdämpfung (NEXT): Verhältnis zwischen Eingangssignal und Übersprechen am Ende der Strecke.

Die Kabel werden nach diesen Parametern in Link-Klassen eingeteilt (ISO/IEC 11801: A–D; spätere Erweiterungen: E, F).

Kupferkabel zeichnen sich durch ihre einfache Handhabung aus, sind preisgünstig und unterstützem Auto-Sensing in Ethernet.

Nachteile: Begrenzte Übertragungsdistanz, höhere Kosten durch Brandschutz und Zuglast, Anfälligkeit für Störungen im Vergleich zu Glasfaser.

Insgesamt bieten Kupferkabel eine kostengünstige und flexible Lösung, besonders für kurze bis mittlere Distanzen, während für große Bandbreiten oder störungsfreie Langstrecken häufig Glasfaser bevorzugt wird.

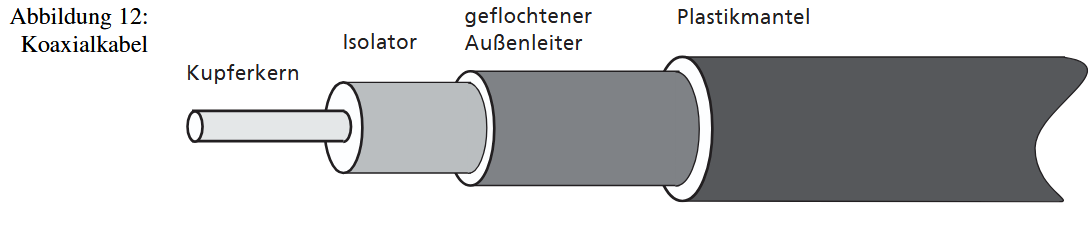

1.5.3. Koaxialkabel

Koaxialkabel optimieren das Prinzip der Abschirmung durch eine zylindrische Bauweise: Ein isolierter Innenleiter (Kupferdraht) wird komplett von einem äußeren Rückleiter (das Metallgeflecht oder die Folie, das um die Isolierung herumgewickelt ist) umschlossen. Dieser Aufbau wurde für hochfrequente Signale entwickelt, wie sie etwa beim Fernsehen-Antennen genutzt werden. Zwar bieten sie dadurch exzellente Übertragungswerte und eine deutlich bessere elektromagnetische Verträglichkeit als verdrillte Kabel, doch hat dies seinen Preis: Die Kabel sind teurer, mechanisch steif und daher schwer in Kanälen zu verlegen. Auch das Installieren von Verbindungen oder Abzweigungen ist technisch wesentlich aufwendiger.

1.5.4. Lichtwellenleiter (Glasfaser)

Eine schnelle und effiziente Übertragungsart ist der Datentransport mittel Lichtimpulsen. Licht ist zwar auch elektromagnetische Strahlung, aber mit Frequenzen weit oberhalb der technisch verwendeten. Dadurch ist die potenzielle Bandbreite sehr hoch, denn sie wird theoretisch nur durch die Trägerfrequenz begrenzt.

Die optische Datenübertragung nutzt Lichtimpulse, deren extrem hohe Frequenzen theoretisch enorme Bandbreiten ermöglichen. In der Praxis wird die Geschwindigkeit meist nur durch die optoelektronischen Schaltkomponenten (Bauteile, die Strom in Licht oder Licht in Strom umwandeln können) und Laufzeitverzerrungen begrenzt. Technisch wird Licht aus LEDs oder Lasern in hauchdünne Fasern eingekoppelt (Das Licht muss in das extrem dünne Kabel hineinkommen).

Die Funktionsweise von Glasfasern beruht auf einem lichtleitenden Kern, umgeben von einem Mantel mit niedrigerem Brechungsindex. Das Licht wird durch Totalreflexion innerhalb des Kerns geführt. Der Kern besteht meist aus Quarz, und zur Übertragung wird Infrarotlicht verwendet. Optimal sind Wellenlängen ab 800 nm, da hier drei Dämpfungsminima liegen: 850 nm, 1310 nm und 1550 nm (bei Kunststofffasern liegt das Minimum bei 650 nm).

Wesentliche Bedingungen für die Lichtausbreitung sind:

- der Kern muss einen höheren Brechungsindex als der Mantel haben,

- beide Materialien müssen homogen sein und

- das Licht muss unter einem definierten Winkel eingekoppelt werden.

Es existieren zwei Haupttypen von Glasfasern:

-

Multimodefaser: Für kürzere Entfernungen geeignet. Hier können mehrere Lichtmoden gleichzeitig durch den Kern laufen, wobei die unterschiedlichen Laufwege zu Dispersion führen. Die Lichtimpulse am Faserende werden zeitlich verwischt.

-

Singlemodefaser: Für lange Strecken optimiert. Der Kerndurchmesser ist so klein, dass nur eine Lichtmode möglich ist, wodurch Dispersion praktisch vermieden wird und hohe Bandbreiten über große Entfernungen realisierbar sind.

Da die eigentliche Faser extrem dünn ist, sind diese Kabel flexibler als Koaxialkabel. Während die Herstellungskosten sinken, bleibt die Verbindungstechnik aufgrund der nötigen Präzision anspruchsvoll. Ein entscheidender Vorteil dieses Systems ist jedoch die unübertroffene Abhörsicherheit sowie die völlige Unempfindlichkeit gegenüber elektromagnetischen Störungen.

Wichtige Begriffe

Lichtimpuls: Das eigentliche Datensignal. Anstatt Strom ein- und auszuschalten (wie bei Kupferkabeln), wird hier Licht extrem schnell an- und ausgeschaltet (blinken). Ein Lichtblitz steht für eine „1“, kein Licht für eine „0“.

Optoelektronische Schaltkomponente: Die "Übersetzer-Bauteile" an den Enden des Kabels. Auf der Senderseite (z. B. Laser/LED): Wandelt elektrischen Strom vom Computer in Licht um. Auf der Empfängerseite (z. B. Photodiode): Wandelt das empfangene Licht wieder in elektrischen Strom um. Wichtig: Sie sind oft der Flaschenhals, der die Geschwindigkeit begrenzt, da sie nicht unendlich schnell schalten können.

Lichtleitender Kern: Das Herzstück der Glasfaser. Dies ist der hauchdünne Zylinder in der Mitte des Kabels, durch den das Licht tatsächlich reist. Er muss aus extrem reinem Material sein, damit das Licht nicht „steckenbleibt“.

Brechungsindex: Eine physikalische Kennzahl, die angibt, wie „dicht“ ein Material für Licht ist und wie stark es Licht ablenkt. Damit das Kabel funktioniert, muss der Kern einen höheren Brechungsindex haben als der ihn umgebende Mantel. Das sorgt dafür, dass das Licht im Kern "gefangen" bleibt.

Totalreflexion: Das physikalische Prinzip, das die Datenübertragung erst möglich macht. Wenn das Licht im Kern auf die Grenze zum Mantel trifft, tritt es nicht nach außen aus, sondern wird wie an einem perfekten Spiegel zu 100 % in den Kern zurückgeworfen. So kann das Licht kilometerweit „zickzack“ durch das Kabel reisen, ohne verloren zu gehen.

Quarz: Chemisch Siliziumdioxid. Es ist das Material, aus dem der Kern meist besteht. Es handelt sich um extrem hochreines Glas (viel reiner als Fensterglas), das Licht fast ohne Verluste hindurchlässt.

Infrarotlicht Licht: das für das menschliche Auge nicht mehr sichtbar ist (Wellenlänge ist länger als bei Rot). Es wird verwendet, weil es in Glasfasern weniger stark abgeschwächt (gedämpft) wird als sichtbares Licht.

Wellenlänge: Gibt die „Farbe“ oder Art des Lichts an (gemessen in Nanometern, nm). Unterschiedliche Wellenlängen verhalten sich im Glas unterschiedlich. Beispiel: 850 nm, 1310 nm, 1550 nm.

Dämpfungsminimum: Ein "Sweet Spot" (Idealbereich). Jedes Material schluckt Licht. Bei bestimmten Wellenlängen (den Dämpfungsminima) ist Glas jedoch besonders durchlässig. Man wählt genau diese Wellenlängen für die Übertragung, um die Reichweite zu maximieren und Signalverluste zu minimieren.

Lichtmode: Der Weg, den ein Lichtstrahl durch den Kern nimmt.

1.5.5 Übertragung im freien Raum

Die Ausbreitung elektromagnetischer Wellen ist nicht an Leiter gebunden. Diese Wel- len können sich auch in Vakuum und Luft ausbreiten. Optische Verfahren wie Infrarot erfordern jedoch Sichtverbindung und sind wetterabhängig.

Mikrowellen sind robuster, benötigen aber meist ebenfalls Richtfunk, während Radiofrequenzen unter Störungen und Frequenzknappheit leiden. Eine Schlüsseltechnologie sind geostationäre Kommunikationssatelliten, die in 36.000 km Höhe scheinbar stillstehen. Sie fungieren als Relaisstationen, indem sie Signale empfangen und auf anderen Frequenzen zurücksenden. Trotz ihrer Vorteile als stabile Vermittler stellt die physikalisch bedingte Signallaufzeit von über einer Viertelsekunde eine relevante technische Einschränkung dar.

1.6. Kanalodierung

In der modernen Datenübertragung hat sich die binäre Codierung als absoluter Standard etabliert. Eine wichtige Ausnahme bildet lediglich der Ruhezustand, bei dem kein Signal anliegt, um zu signalisieren, dass das Übertragungsmedium gerade frei ist. Damit der Empfänger die ankommende Folge von Nullen und Einsen korrekt interpretieren kann, ist eine exakte Synchronisation mit dem Sender unerlässlich. Der Empfänger muss den Takt (die Abtastrate) kennen, um zu wissen, wann ein Bit endet und das nächste beginnt. Dieser Takt wird entweder über separate Steuerleitungen (SYNC, STROBE) übertragen oder, was technisch eleganter ist, direkt aus dem Datensignal selbst gewonnen. Verfahren wie „Phase Locked Loops“ (PLLs) nutzen dafür die regelmäßigen Signalflanken (Pegeländerungen) des Datenstroms, um den Takt zu rekonstruieren.

Der entscheidende Vorteil der digitalen gegenüber der analogen Übertragung liegt in ihrer enormen Widerstandsfähigkeit gegen Störungen. Auf dem Weg durch das Kabel wird jedes Signal durch Dämpfung abgeschwächt, durch Dispersion verzerrt und von Rauschen überlagert. Solange diese Verfälschungen jedoch einen kritischen Grenzwert nicht überschreiten, kann der Empfänger eindeutig entscheiden, ob eine „0“ oder eine „1“ gesendet wurde. Die Information lässt sich also vollständig und fehlerfrei wiederherstellen (regenerieren).

Dies erlaubt eine wichtige Abstraktion: Auf der Bitübertragungsebene ist es irrelevant, wie die Bits physikalisch transportiert werden. Ob es sich um Lichtimpulse in einer Glasfaser oder elektrische Spannungssprünge in einem Kupferkabel handelt, spielt für die Logik keine Rolle. Die notwendige Übersetzung zwischen den logischen Bits und dem physikalischen Medium übernehmen dabei spezielle Koppelelemente, die als Transceiver bezeichnet werden.

1.7. Übertragungsprotokoll

Die Vorschriften zur Übertragung von Daten (Zahlen auf Bitebene) werden Übertragungsprotokoll genannt.

Das Übertragungsprotokoll ist eine Datenaustausch-Vorschrift.

Rahmen

Die Rahmenbildung ist die eindeutige Kennzeichnung von Anfang und Ende einer Übertragungseinheit.

Damit eine Empfangsstation zwischen dem Ruhezustand der Leitung und einem Signal unterscheiden kann, werden Daten in Übertragungsrahmen zusammengefasst. Dies setzt voraus, dass Sender und Empfänger synchronisiert sind. Bei der heute vorherrschenden synchronen Übertragung wird der notwendige Takt direkt aus dem Leitungssignal gewonnen. Spezielle Synchronisationsmuster stellen dabei sicher, dass genügend Pegelwechsel vorhanden sind und der Beginn der Übertragung eindeutig erkannt wird.

Bitsynchrone und Bytesynchrone Übertragung

Man differenziert zwischen bitsynchroner und bytesynchroner Übertragung. Während bei der bytesynchronen Methode spezielle Zeichen (wie SYN) zur Synchronisation dienen, nutzt die bitsynchrone Variante festgelegte Bitfolgen ( 0111 1110 = 7EHEX = gennant Flags). Ein zentrales Erfordernis ist, dass diese spezifischen Muster nicht innerhalb der eigentlichen Nutzdaten vorkommen dürfen.

Datenrahmen

Abzugrenzen von der reinen Synchronisation sind die Datenrahmen, welche die Informationen logisch gruppieren. Bei bytesynchronen Verfahren definieren reservierte Steuerzeichen wie SOH oder ETX den Aufbau. Bei der bitsynchronen Übertragung hingegen wird die Struktur durch feste Positionen relativ zum startenden Flag bestimmt.

Bei bytesynchroner Übertragung geschieht dies z. B. durch die Zeichenfolge SOH <HEADER> STX <Daten> ETB/ETX.

Die Zeichen SOH (start of header), STX (start of text), ETB (end transmitting block) und ETX (end of text) sind Zeichen des ASCII oder des EBCDIC Codes. Diese Zeichen dürfen auch nicht mehr im Datenstrom vorkommen, d. h. sie sind reserviert. Bei bitsynchroner Übertragung erfolgt eine Datenrahmenbildung durch bestimmte Positionen im Datenstrom (ab Flag gerechnet).

1.7.1. Transparenz

Eine Übertragungsart ist transparent, wenn sie beliebige Zeichen (Bitfolgen) übertragen kann.

Transparenz in Protokollen bedeutet, beliebige Daten als Nutzlast (Payload) zu versenden, ohne dass diese mit organisatorischen Steuerinformationen verwechselt werden. Da bestimmte Muster für die Rahmenbildung reserviert sind, muss verhindert werden, dass diese in den Nutzdaten fälschlich als Steuerbefehle interpretiert werden. Bei der bitsynchronen Übertragung nutzt man Stopfbits (Bit Stuffing). Hierbei wird nach fünf Einsen automatisch eine Null eingefügt und empfängerseitig entfernt, um das Flag-Muster zu vermeiden.

Die bytesynchrone Übertragung verwendet stattdessen „Escaping“ mit einem Ausweichzeichen (DLE). Reservierte Zeichen im Datenstrom werden durch ein vorangestelltes DLE maskiert. DLE wird dadurch übertragen, dass statt einmal DLE das DLE zweimal gesendet wird.

1.7.2. Fehlererkennung

Auch bei digitaler Übertragung treten Störungen auf, die Daten verfälschen. Um Fehler zu erkennen oder zu korrigieren, muss zusätzliche, redundante Kontrollinformation übertragen werden, deren Umfang sich nach der Bitfehlerrate und gewünschten Qualität richtet.

Paritätsprüfung

Die einfachste Form ist die Parität. Ein Paritätsbit ergänzt die Datenbits so, dass ihre Gesamtsumme entweder gerade oder ungerade ist (technisch realisiert durch XOR). Dieses Verfahren erkennt zuverlässig Einzelbitfehler pro Rahmen, versagt jedoch bei zwei Fehlern, da sich diese gegenseitig aufheben. Man legt z.B. fest, dass immer ein gerade Anzahl an Einsen in einem Paket geschickt wird. Schickt man das Buchstaben 'A' ist die NAzahl der Einsen schon gerade (0 1 0 0 0 0 0 1) -> man hängt eine 0 als Paritätsbit dran: Geschickt wird: 0 1 0 0 0 0 0 1 0.

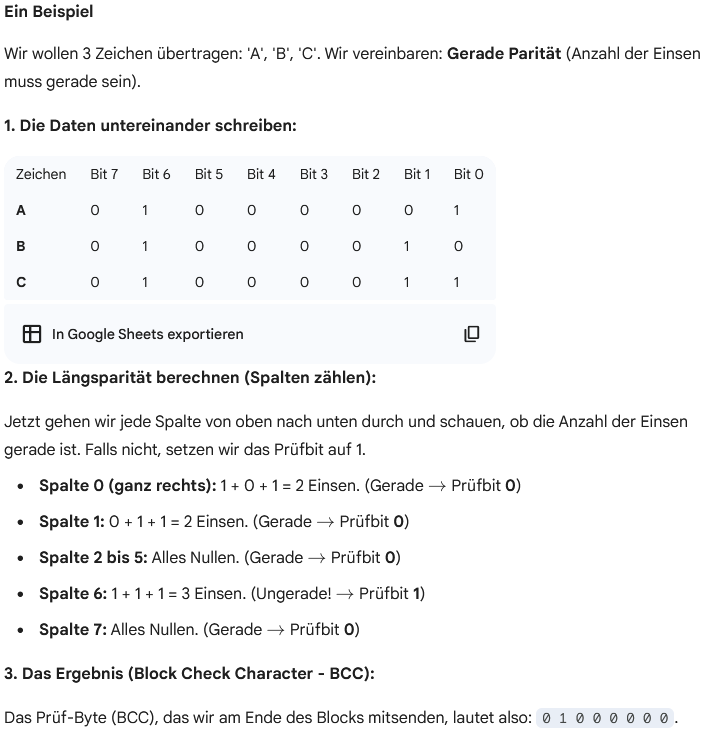

Längsparität (LRC)

Bei der bytesynchronen Übertragung wird die Längsparität (LRC) genutzt. Hierbei wird über alle Bytes hinweg für jede Bitposition ein Paritätsbit berechnet, was zusammengefasst ein Prüfzeichen (BCC) ergibt. Dies ist sicherer als einfache Parität, erkennt aber ebenfalls keine Doppelfehler an derselben Bitposition. Der Redundanzanteil ist über die Blocklänge steuerbar.

Zyklische Redundanzprüfsumme (CRC)

Die leistungsfähigste Methode ist der CRC (Cyclic Redundancy Check). Sie basiert mathematisch auf Polynomdivisionen durch ein Generatorpolynom, dessen Rest als Prüfsumme (FCS) dient. Technisch wird dies effizient durch Schieberegister und XOR-Gatter in Hardwarebausteinen (z.B. Plattencontroller) realisiert und bietet eine sehr hohe Erkennungsrate.

1.7.4. Fehlerkorrektur

Nach der Erkennung von Fehlern hat man auch Möglichkeiten für deren Korrektur. Es werden 3 Methoden zur Fehlerkorrektur unterschieden:

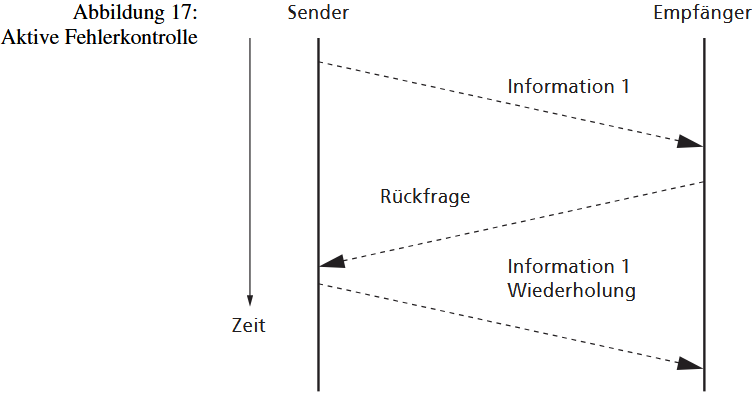

- aktive Fehlerkontrolle (Empfänger veranlasst Übertragungswiederholung)

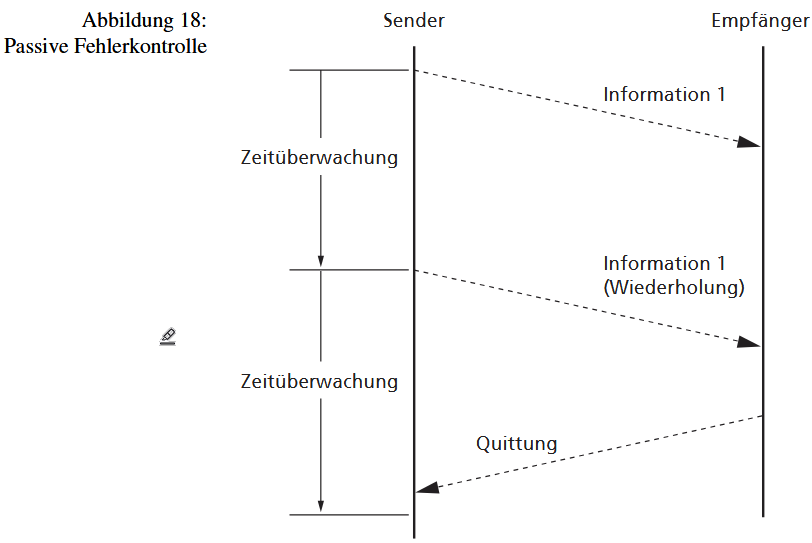

- passive Fehlerkontrolle (Sender veranlasst Übertragungswiederholung)

- Vorwärtsfehlerkorrektur (Empfänger erkennt und korrigiert Fehler)

Bei der aktiven und passiven Fehlerkontrolle wird der Information lediglich so viel Redundanz hinzugefügt, dass der Empfänger Fehler erkennen, aber nicht selbstständig korrigieren kann. Der Sender erfährt durch eine Quittung des Empfängers, ob die Daten korrekt angekommen sind. Der Unterschied zwischen beiden Verfahren liegt in der Reaktion auf einen Fehler.

Bei der aktiven Fehlerkontrolle fordert der Empfänger explizit eine Wiederholung an, sobald er einen Fehler erkennt. Dies birgt jedoch Risiken: Ist die Rückfrage selbst gestört, kann es zu Endlosschleifen oder Verklemmungen kommen.

Im Gegensatz dazu verhält sich der Empfänger bei der passiven Fehlerkontrolle im Fehlerfall still. Der Sender bemerkt das Ausbleiben der Quittung (ACK)durch eine Zeitüberwachung (Timeout) und sendet die Daten erneut. Hierbei kann es zur Informationsverdoppelung kommen, falls lediglich die Quittung verloren ging. Um Endlosschleifen bei dauerhaften Störungen zu verhindern, muss die Anzahl der Wiederholungen in beiden Fällen begrenzt werden.

Vorwärtsfehlerkorrektur

Die Vorwärtsfehlerkorrektur (englisch: Forward Error Correction, FEC) ist eine Technik, bei der der Sender Daten so aufbereitet, dass der Empfänger Übertragungsfehler nicht nur erkennen, sondern selbstständig reparieren kann, ohne den Sender um eine erneute Übermittlung bitten zu müssen.

In der Praxis werden Daten- und Redundanzbits häufig im Bitstrom verteilt (Interleaving): Sie werden nicht stur nacheinander verschickt, sondern "zusammengewürfelt". Dadurch betreffen gebündelte Störungen (Burst Errors), bei denen ganze Abschnitte ausfallen, lediglich einzelne Bits verschiedener Korrekturrahmen, was die Wiederherstellung erleichtert.

Allerdings erkauft man sich diese Sicherheit durch einen signifikanten Verlust an Netto-Bandbreite. Die Wahl des Verfahrens hängt von der erwarteten Fehlerhäufigkeit, der Leitungskapazität und der tolerierbaren Verzögerung ab. Während FEC typischerweise bei internen Übertragungen (CPU, Speicher) genutzt wird, kommen bei Distanzkommunikation eher aktive oder passive Fehlerkontrollverfahren zum Einsatz.

Man nennt diese Form der Fehlerkorrektur "vorwärts", weil die Übertragung nur in eine Richtung fließt, da der Empfänger im Fehlerfall die Daten selbst korrigieren kann. Im Gegensatz dazu, werden die aktive und passive Fehlerkorrektur als ARQ (Automatic Repeat reQuest) bezeichnet. Dabei fließt die Übertragung in zwei Richtungen.

1.7.5. Sequenzkontrolle

Manchmal kann es vorkommen, dass Daten im Fehlerfall wiederholt übertragen werden. Eine Wiederholung heißt aber nicht automatisch, dass ein Fehler vorliegt. Aus diesem Grund sollte man solche Wiederholungen erkennen. Dieser Mechanismus wird als Sequenzkontrolle bezeichnet. Sequenzkontrolle dient also in erster Linie dazu, Informationsverdoppelung zu erkennen.

Eine Sequenznummer ist eine fortlaufende Nummerierung von Informationsrahmen zu ihrer Identifikation. Bei Informationswiederholung wird keine neue Nummer zugeteilt, sondern die zuvor verwendete beibehalten. Erhält der Empfänger einen Informationsrahmen mit einer Sequenznummer, die er schon verarbeitet hat, dann muss es sich um eine Wiederholung handeln. Der Empfänger quittiert die Information, verarbeitet sie jedoch nicht weiter.

Die Vergabe rotierender Sequenznummern spart Übertragungskapazität, da nur benachbarte Rahmen unterschieden werden müssen. Die Quittung kann die Nummer des letzten fehlerfrei empfangenen Rahmens enthalten und bestätigt damit implizit alle vorherigen Rahmen. Dies erlaubt dem Sender, Rahmen kontinuierlich zu verschicken, ohne nach jedem Einzelrahmen auf eine Bestätigung warten zu müssen.

1.7.6. Flusskontrolle

Auch Unterschiede in der Verarbeitungskapazität können Probleme bereiten. Falls der Sender Informationen schneller überträgt, als der Empfänger sie verarbeiten kann, kann es zu Datenstaus oder Datenüberlauf kommen. Der Empfänger soll in der Lage sein, den Datenfluss zu bremsen. Durch diesen Mechanismus können Geräte unterschiedlicher Verarbeitungsgeschwindigkeit Informationen austauschen.

Durch die Flusskontrolle wird die Übertragungsgeschwindigkeit nicht beeinflusst, sondern nur die durchschnittliche Datenrate (Datenmenge/Zeit). Die Flusskontrolle kann das Kabel nicht schneller machen, aber sie kann den Datenfluss bremsen, indem sie den Sender pausiert. Dadurch bleibt die maximale Geschwindigkeit des Mediums unberührt, aber die Nettomenge der in einer Sekunde angekommenen und verarbeiteten Daten sinkt.

Die Flusskontrolle ist ein Mechanismus zur Anpassung der Datenrate an die Leistungsfähigkeit des Empfängers. Man unterscheidet Handshake, Kredit- und Fenstermethode.

Handshake

Der Handshake nutzt spezielle Bitfolgen oder Rahmen als Bremsinformation, die aufgrund von Lauf- und Reaktionszeiten rechtzeitig gesendet werden muss und einen Reservepuffer erfordert. Alternativ nutzt der Hardware-Handshake spezielle Leitungen, deren Pegel die Sendeerlaubnis regelt, was aber nur über kurze Entfernungen kosteneffizient ist.

Kredite

Eine andere Klasse von Methoden basiert auf der Berechtigung durch den Empfänger. Bei der Kredit-Methode erteilt der Empfänger dem Sender explizite Kredite (z. B. Anzahl der zu sendenden Bytes). Sind diese erschöpft, muss der Sender auf neue warten.

Fenster-Mechanismus

Verwandt ist der Fenster-Mechanismus: Hierbei hat der Sender einen impliziten Kreditrahmen (w Informationsrahmen). Jede vom Empfänger erhaltene Quittung schiebt dieses Fenster weiter, sodass der Sender kontinuierlich Daten senden kann, solange das Fenster nicht ausgeschöpft ist.

1.7.7. Fragmentierung

Fragmentierung ist die Aufteilung eines logischen Rahmens (Satz, Record) auf mehrere aufeinanderfolgende physikalische Rahmen (Übertragungsrahmen).

Die Unterteilung von Datenströmen in begrenzte Übertragungsrahmen ist unverzichtbar, obwohl der damit verbundene Overhead die Effizienz mindert. Eine kontinuierliche Übertragung ohne Unterteilung ist aus mehreren technischen Gründen nicht zielführend.

-

Erstens steigt mit der Länge eines Rahmens die Wahrscheinlichkeit für Übertragungsfehler signifikant an. Im Fehlerfall müsste eine riesige Datenmenge erneut gesendet werden, was die effektive Durchsatzrate drastisch senkt.

-

Zweitens verlieren Fehlererkennungsverfahren bei zu großen Datenblöcken an Zuverlässigkeit, da die Wahrscheinlichkeit unerkannter Mehrfachfehler wächst.

-

Drittens erschwert eine unbegrenzte Länge die Synchronisation auf den Rahmenbeginn und erfordert unverhältnismäßig große Puffer für die Flusskontrolle beim Empfänger.

Wenn die zu übertragende logische Informationseinheit (z. B. ein Datensatz) die maximale Kapazität eines physikalischen Rahmens überschreitet, muss eine Fragmentierung (Segmentierung) erfolgen. Die Daten werden auf mehrere Pakete verteilt. Um die logische Zusammengehörigkeit für den Empfänger zu wahren, sind Kennzeichnungen erforderlich. Bei bytesynchronen Verfahren markieren spezielle Separatorzeichen das Ende einer Einheit. In bitsynchronen Protokollen wie X.25 wird oft ein „More Data“-Bit im Header gesetzt, um zu signalisieren, dass der aktuelle Rahmen nur ein Teilstück ist und die logische Einheit im nächsten Paket fortgesetzt wird.

1.7.8. Blockung

Datenblockung (Füllung) ist die Zusammenfassung mehrerer logischer Rahmen zu einer Übertragungseinheit. Blockung und Fragmentierung verteilen die logischen Dateneinheiten so auf Übertragungseinheiten, dass die Übertragungsstrecke effizienter genutzt wird.

Um die schlechte Effizienz bei kleinen Datenmengen auszugleichen, fasst man mittels Blocking mehrere logische Einheiten in einem einzigen physikalischen Übertragungsrahmen zusammen.

1.7.9. Multiplex

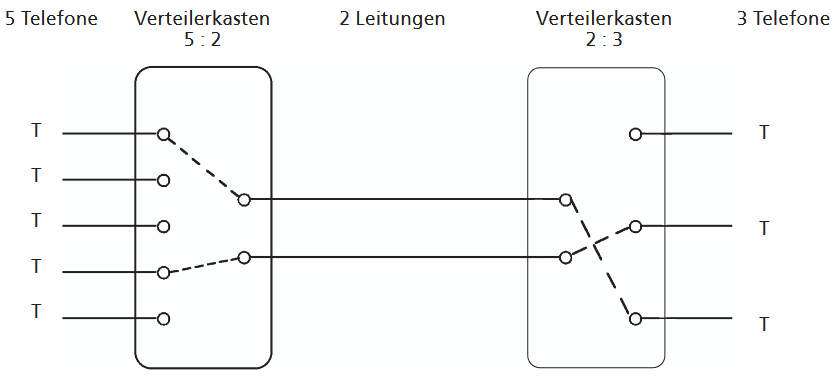

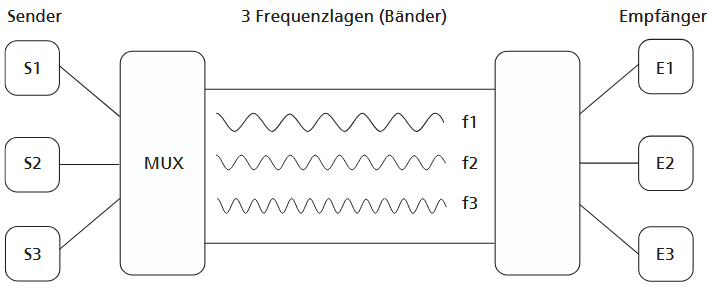

Unter Multiplex versteht man die gemeinsame Benutzung einer DÜ-Einrichtung durch mehrere Datenströme. Es gibt die Multiplexarten Raummultiplex, Zeitmultiplex, Frequenzmultiplex und Codemultiplex. Dadurch wird eine physische Übertragungseinrichtung für mehrere Kommunikationen gleichzeitig nutzbar.

Raummultiplex

Die internationale Bezeichnung ist SDM: space division multiplex. Auf einem Leitungsbündel werden mehrere Übertragungen/Verbindungen gleichzeitig realisiert. Pro Verbindung wird eine Leitung (2 bzw. 4 Drähte) verwendet.

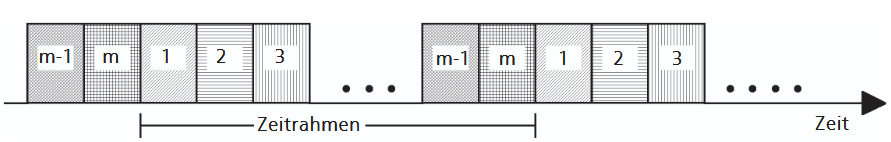

Zeitmultiplex

Die internationale Bezeichnung ist TDM: time division multiplex. Eine physikalische Verbindung (Leitung, Glasfaser, …) wird in zeitlicher Verschachtelung für die Übertragung mehrerer Datenströme verwendet. Werden m Datenströme übertragen, so wird jedem Datenstrom eine Zeitlage (Zeitfenster, time slot) reserviert. Nach m Zeitlagen (= 1 Zeitrahmen) wiederholen sich die Zeitlagen. Das heißt, jede Datenquelle darf pro Zeitrahmen 1 mal 1 Zeitlage lang senden. In einer Zeitlage (Abtastdauer) muss die Information übertragen werden, die ohne Multiplex in einem Zeitrahmen gesendet würde, sie wird also um das m-fache zeitlich komprimiert.

An beiden Enden der Übertragungsstrecke sind elektronische Schalter (Multiplexer, Demultiplexer) erforderlich, die genauestens synchronisiert werden müssen, um die Zeitlagen der einzelnen Sender und Empfänger zuzuordnen.

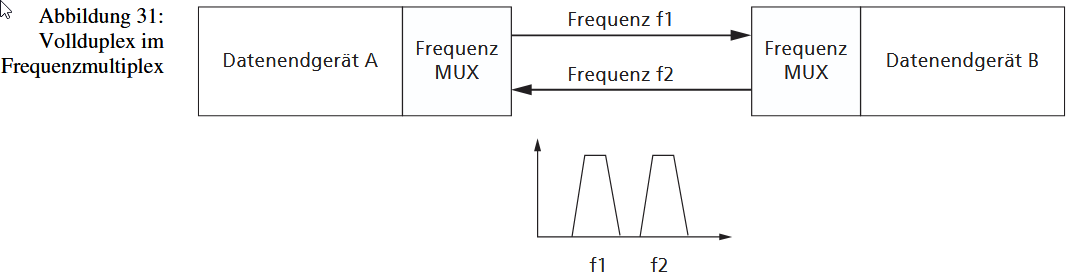

Frequenzmultiplex

Die internationale Bezeichnung ist FDM: frequency division multiplex.

Dabei teilt man die Datenströme (im selben Kabel) mittels Modulation in mehrere Frequenzbänder auf.

- Aufteilung: Jeder Datenstrom bekommt seine eigene "Fahrspur" (eine eigene Trägerfrequenz).

- Gleichzeitigkeit: Alle Datenströme können gleichzeitig über dasselbe Kabel fließen, ohne sich zu stören, weil sie auf unterschiedlichen Frequenzen "reisen" (wie Radiosender auf verschiedenen Frequenzen).

- Empfänger: Am Ende trennt der Empfänger die Frequenzen wieder (demoduliert).

Codemultiplex

Die internationale Bezeichnung ist CDM: code division multiplex.

Code Division Multiplexing (CDM/CDMA) ermöglicht die gleichzeitige Übertragung mehrerer Datenströme auf demselben Übertragungskanal (Trägerfrequenz). Die Trennung der Signale erfolgt hierbei weder zeitlich noch frequenzmäßig, sondern durch mathematische Codierung. Jeder Sender multipliziert seine Nutzdaten mit einer einzigartigen, senderspezifischen Code-Sequenz (Spreizcode / Pseudo Noise Sequence), wodurch das Signal über eine größere Bandbreite verteilt wird. Diese Codes sind orthogonal zueinander gewählt (ihre Korrelation ist 0), sodass sie sich mathematisch nicht stören. Für den Empfänger erscheinen fremde Signale lediglich als Hintergrundrauschen; durch Korrelation (Faltung) mit dem korrekten Code kann er jedoch das gewünschte Nutzsignal aus dem "Signalgemisch" herausfiltern und rekonstruieren. Da ein Nutzbit auf viele Code-Bits verteilt wird, teilen sich alle Teilnehmer die effektive Bitrate des Mediums.

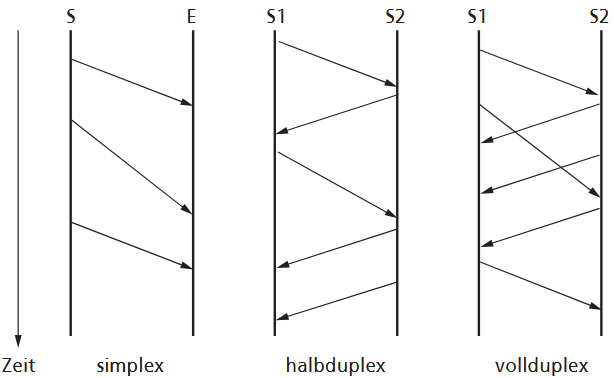

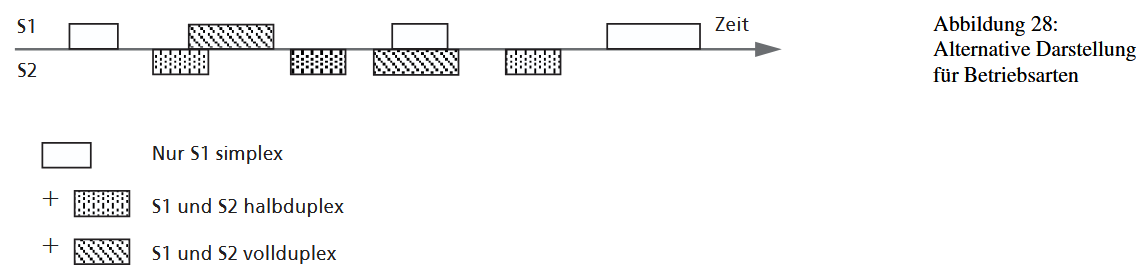

1.7.10. Übertragungsrichtung

Informationen werden häufig in beiden Richtungen übertragen.

In der Praxis unterscheiden wir drei Betriebsarten:

- simplex (sx): unidirektionale Datenübertragung, d.h. die Informationen fließen nur in eine Richtung

- halbduplex (hdx): bidirektional alternierende DÜ, d.h. die Informationen fließen in beiden Richtungen aber nicht gleichzeitig

- vollduplex (fdx): biderektionale DÜ, d.h. die Informationen fließen in beiden Richtungen gleichzeitig.

Das Raummultiplex gestattet die Nutzung von zwei physischen Verbindungen (vier Drähte) als eine logische fdx Verbindung.

Mithilfe des Zeitmultiplex kann eine physische Verbindung (ein Draht) alternierend in beiden Richtungen übertragen, also hdx-Betrieb herstellen.

Das Frequenzmultiplexverfahren gestattet sogar auf einer physischen Verbindung die fdx Betriebsart, indem die Bandbreite der Verbindung in 2 Kanäle (einen Hin- und einen Rückkanal) aufgeteilt wird.

1.8. Übertragungseinrichtungen

1.8.1. Analog-Modems

Modems werden dann verwendet, wenn man von einem Rechner zu einem anderen Rechner eine Verbindung aufbauen will und nur einen herkömmlichen analogen Telefonanschluss zur Verfügung hat. Dabei muss der Modem die digitalen Daten aus dem Computer aufmodulieren (für den analogen Telefonnetz "übersetzen", d.h. in Frequezwellen umwandeln)

Im Englischen sagt man zu diesem oft ironisch-nostalgisch POTS: plain old telephone service.

Das Telefonnetz ist zur analogen Übertragung von Sprache in einem Frequenzbereich von etwa 300 bis 3400 Hz ausgelegt. Es ist für die diskrete Codierung mit Signalpegeln nur sehr mäßig geeignet, man hat sich deshalb in der Urzeit der Datenübertragung dazu entschlossen, Modulationen von Einzelfrequenzen zur Codierung auf dem analogen Übertragungsweg zu benutzen.

1.8.2. 56K-Modems (V.90)

Die V.90-Technik ermöglicht die höchste Datenrate über herkömmliche Telefonleitungen, setzt jedoch voraus, dass das Telefonnetz bis zur letzten Vermittlungsstelle vor dem Kunden vollständig digitalisiert ist. Auf dieser digitalen Seite wird mittels Pulse Code Modulation (PCM) gearbeitet, die analoge Signale mit einer Abtastrate von 8 kHz (8.000 Mal pro Sekunde) und 8 Bit Tiefe digitalisiert. Dabei kommt eine nichtlineare Quantisierung zum Einsatz, die leise Töne feiner auflöst als laute, um die Dynamik des menschlichen Gehörs besser abzubilden.

Um Daten zu übertragen, nutzt die Gegenstelle (Provider) genau jene Spannungswerte, die am Ende der Leitung bei der Rückwandlung in der Vermittlungsstelle exakt den ursprünglichen digitalen PCM-Werten entsprechen. Dieser Vorgang erfordert eine stabile Leitung und eine anfängliche Kalibrierung ("Aushandeln") zwischen Sender und Empfänger, um Dämpfungseffekte auszugleichen. Da das achte Bit in manchen Netzwerken für Steuerzwecke reserviert ist und technisch schwer präzise zu übertragen ist, werden effektiv nur 7 Bits genutzt, was rechnerisch zu den bekannten 56 kBit/s führt.

Die maximale digitale Datenrate ergibt sich aus der Multiplikation dieser beiden Faktoren:

8.000 Abtastungen/s × 7 Bits/Abtastung=56.000 Bits/s

Dieses Verfahren ist asymmetrisch konzipiert. Während der Download vom Provider zum Kunden die hohe Rate von 56 kBit/s erreicht, bleibt der Upload vom Kunden zum Provider auf herkömmliche analoge Verfahren mit maximal 33.600 Bit/s beschränkt. Dies ist technisch bedingt, da die präzise Synchronisation der Spannungswerte in Richtung der Analog-Digital-Wandlung beim Kunden extrem aufwendig wäre. Dennoch unterliegt auch diese Technik dem Shannon-Theorem: Ist die Leitungsqualität schlecht (zu viel Rauschen), fallen die Modems automatisch auf langsamere, robustere analoge Übertragungsraten zurück.

1.8.3. ISDN

Die rasante Entwicklung digitaler Vermittlungstechnik und die steigende Nachfrage nach digitalen Diensten (Telefax, Daten) machten das analoge Telefonnetz unzeitgemäß. Daher rückte die digitale Schnittstelle schrittweise näher zum Teilnehmer, was zur Entwicklung des Integrated Services Digital Network (ISDN) führte. ISDN ist ein diensteintegrierendes Netz, das den Transport von Sprache und Daten gleichermaßen und digital über dieselben Leitungen ermöglicht. Erst mit ISDN war die gesamte Verbindungskette, von Teilnehmer zu Teilnehmer, vollständig digital.

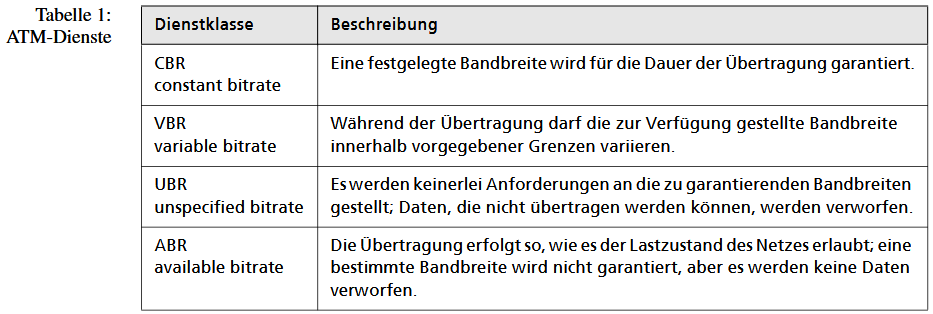

Der Standardanschluss (S0) für Endkunden enthielt zwei B-Kanäle (Leitungen zu je 64 kBit/s), die flexibel für Sprache oder Daten genutzt werden konnten. Für höhere Kapazität (z.B. große Nebenstellenanlagen) wurde der Primäranschluss (S2M) mit 30 B-Kanälen angeboten. Obwohl ISDN die digitale Übertragung zum Standard machte, setzte sich die nachfolgend geplante Technologie für Breitband-ISDN (B-ISDN) auf Basis von ATM (Asynchronous Transfer Mode) in Deutschland beim Endkunden nicht durch.

1.8.4. DSL (digital subscriber line)

Die xDSL-Techniken nutzen das letzte Stück der Kupferleitung vom Kunden zur Vermittlungsstelle, indem sie durch Weglassen von Bandsperren ein breitbandigeres Frequenzspektrum verfügbar machen. Die erforderlichen DSLAMs in der Vermittlungsstelle und spezielle Endgeräte beim Kunden ermöglichen MBit/s-Kapazitäten auf analogen oder ISDN-Leitungen.

Die Nutzung ist auf kurze Entfernungen beschränkt, da mit steigender Distanz die Dämpfung und der Störpegel zunehmen, was die erzielbare Datenrate nach dem Shannon-Theorem limitiert. Dies führt zu einem Stadt-Land-Gefälle, da dort zusätzliche Investitionen in DSLAMs nötig sind.

ADSL (asymmetrisch) nutzt Frequenzmultiplexing, um den Download gegenüber dem Upload zu priorisieren. Für Geschäftskunden ist SDSL (symmetrisch) besser geeignet. Um höhere Datenraten zu erreichen, muss auf die Frequenzbereiche der Telefonie verzichtet werden. Die Telefonie wird dann als VoIP (Voice over IP) im Datenstrom abgewickelt, wodurch die besonders effizienten niedrigen Frequenzen für die DSL-Daten freigegeben werden.

1.8.5. Kabelnetz

Die TV-Kabeltechnik nutzt Koaxialkabel mit sehr hohen Frequenzen, die ungenutzte Kapazitäten (400–800 MHz) für digitales Fernsehen und Datenübertragung mittels Frequenzmultiplex bereitstellen. Aufgrund des besseren Kabeltyps sind die Bandbreiten und Datenraten höher als auf herkömmlichen Kupferdoppeladern (DSL). Allerdings müssen die Verteilknoten für bidirektionalen Verkehr (Upstream/Downstream) aufgerüstet werden.

Im Gegensatz zu DSL, wo die Leitung dediziert ist, müssen sich die Kunden auf dem TV-Kabel die Datenrate bis zum ersten Verteilknoten teilen. Dies führt dazu, dass der Preis pro MBit wirtschaftlich mit DSL vergleichbar ist. Der Marktanteil dieser Anschlussart ist in Deutschland historisch gering. Dies liegt daran, dass die frühere Bundespost als Monopolist tätig war und die Technologie zugunsten ihrer eigenen, fest verknüpften ISDN- und DSL-Infrastruktur unterdrückte.

1.8.6. Mobilfunk

Die ersten Verfahren für mobilen Datenzugriff (WAP) waren auf die geringe Übertragungsrate der Sprachnetze beschränkt. Eine Zwischenlösung war HSCSD, das zur kurzzeitigen Erhöhung der Datenrate freie Sprachkanäle bündelte, aber nur in schwach ausgelasteten Netzen sinnvoll war.

Der entscheidende Wandel kam mit GPRS (General Packet Radio Service), das auf paketvermittelten Datentransport umstellte. Teilnehmer teilen sich dabei den physikalischen Kanal via Zeitmultiplex. Dies führte konsequenterweise zur Abrechnung pro Datenvolumen statt pro Zeit.

Die Weiterentwicklung zu UMTS zielte auf deutlich höhere Bandbreiten ab und nutzt moderne Verfahren wie Code-Multiplex. Allerdings unterliegt diese Technik dem Shannon-Theorem; die höchsten Raten sind nur in der Nähe von Relaisstationen (hot spots) erreichbar. Die Funkzelle als technische Grundlage ist eine effektive Methode, um den Anschluss an den Endkunden ohne verlegte Leitungen zu überbrücken und damit die sogenannte "dirty last mile" zu überwinden.

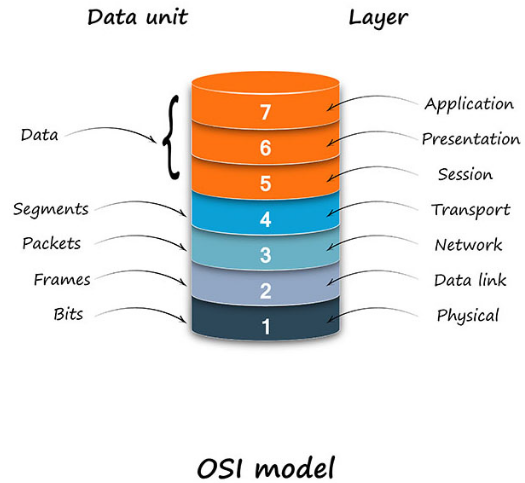

2.1. Das OSI-Referenzmodell

Das OSI-Modell wurde entwickelt, um eine gemeinsame und herstellerneutrale Plattform für den Austatusch von Informationen zwischen Systemen unterschiedlicher Hersteller zu schaffen.

Um die Kommunikation unter heterogenen System zu ermöglichen, wurde früher Schnittstellen, Interfaces (z.B. Code eines Computers in eine andere Sprache zu übersetzen, die von einem anderen Computer verstanden wurde) und Protokolle definiert. Auf diese Art und Weise war die Kommunikation zwar möglich, aber auch aufwendig und teuer.

Deshalb entstand die Überlegung, Herstellen auf einen gewissen Standard einigen zu lassen und Systeme im vorneherein auf Kommunikation mit unterschiedlichen Systemen auszulegen.

Die Entwicklung eines solchen Standards war das Ziel einer Tagung der ISO 1977 in Genf. Das Ergebnis dieser Tagung war eine Arbeitsgruppe, die in den folgenden fünf Jahren das Referenzmodell für Open Systems Interconnection (OSI) entwarf.

Man kann drei Abstraktionsebenen unterscheiden:

- Basismodell (Architektur von Kommunikationssystemen in 7 Schichten) Die Dienste und Protokolle der einzelnen Schichten und ihre Implementation werden nicht festgelegt.

- OSI-Dienste (Festlegung der Dienste, Zugangspunkte und der Dienstbenutzer pro Schicht) Die Protokolle und ihre Implementation zur Realisierung der Dienste werden nicht festgelegt („Was“).

- OSI-Protokolle (Spezifikation der Protokolle pro Schicht/Dienst, d. h. mithilfe der Protokolle werden die Dienste realisiert) Die Implementation der Protokolle wird nicht festgelegt → technologieunabhängig („Wie“).

2.2 Das OSI-Schichtenmodell

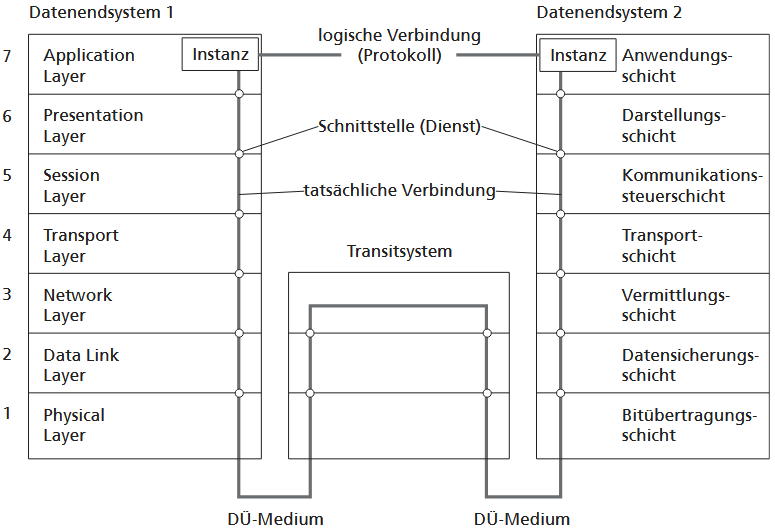

Das OSI-Modell (Open Systems Interconnection) zerlegt den komplexen Kommunikationsvorgang in eine Hierarchie aufeinander aufbauender Funktionsschichten, ähnlich der Modularisierung in der Softwareentwicklung. Das Ziel dieser Schichtung ist es, Flexibilität über verschiedene Technologien hinweg zu erreichen. Eine Kernregel ist, dass die Schichten transparent agieren: Sie tauschen Daten nur über die Schnittstellen der direkt angrenzenden Schichten aus. Für die Instanzen sieht es dabei so aus, als ob sie direkt mit ihrem Partner auf derselben Ebene kommunizieren.

Eine notwendige Konsequenz dieser Architektur ist, dass in Zwischenstationen (Knoten) nur die Schichten vorhanden sein müssen, die für das Routing notwendig sind. Die gewählte Architektur lieferte zwar keine gleich großen Schichten (Session und Presentation Layer sind sehr dünn), hat sich aber durch die Definition der Dienste und Protokolle als Netzwerkarchitektur etabliert.

Obwohl die Implementierung von OSI-Netzwerken kommerziell durch den Siegeszug des Internets (TCP/IP) in den Hintergrund gedrängt wurde, ist das Modell weiterhin eine sehr nützliche Verständigungsbasis. Es dient als Grundlage zur Beschreibung und Gliederung von Rechnernetzen weltweit und hat sich als fundamentaler Rahmen zum Verständnis der Kommunikation durchgesetzt.

2.3. Die Schichten des OSI-Modells

Der Zusammenhang (Bottom-Up) zwischen Schichten: Protokoll ⟶ Funktion ⟶ Dienst

Die Beziehung ist eine Kette von Abhängigkeiten:

-

Protokolle legen fest, wie Partnerinstanzen kommunizieren (z. B. welche Header-Informationen sie austauschen müssen), um bestimmte Funktionen (z. B. Fehlererkennung) durchzuführen.

-

Durch die Ausführung dieser Funktionen (Fehlererkennung, Adressierung etc.) kann die Schicht eine verlässliche und definierte Dienstleistung für die nächsthöhere Schicht bereitstellen.

Die OSI-Schichten

Physical Layer (Bitübertragungsschicht, physikalische Ebene)

Diese Schicht hat die Aufgabe, alle mechanischen (z. B. Stecker), elektrischen (z. B. Signale), funktionellen und prozeduralen Mittel zur Ungesicherten Bitübertragung zwischen Instanzen der Ebene 2 bereitzustellen. Die Dateneinheit ist das Bit.

Data Link Layer (Sicherungsschicht, Link Ebene)

Diese Schicht hat die Aufgabe, alle funktionalen (z. B. Fehlererkennung und -korrektur) und prozeduralen (z. B. Quittungsmechanismus) Mittel zur gesicherten Übertragung von Dateneinheiten (Rahmen, Blöcke = Folge von Bits, frame) zwischen Instanzen der Ebene 3 bereitzustellen.

Die Sicherungsschicht wird in zwei Subschichten aufgeteilt, weil ihre Aufgaben unterschiedlich komplex sind und verschiedene Funktionen erfüllen müssen:

-

Die MAC-Schicht (Sublayer 2a - Medium Access Control) steuert den Zugriff auf das Übertragungsmedium. Sie legt fest, wie Bits auf den physischen Träger gelangen und wie mehrere Stationen den Zugang regeln. Dadurch unterscheidet sie sich je nach LAN-Technologie, etwa durch Verfahren wie Token oder CSMA/CD. Sie steht in direkter Verbindung zur Bitübertragungsschicht. Sie ist zuständig für die physische Adressierung (die MAC-Adresse) und die Rahmenbildung (Framing) der Daten sowie für die Fehlererkennung mittels Prüfsummen. Sie stellt sicher, dass der Rahmen beim korrekten nächsten Empfänger ankommt.

-

Die LLC-Schicht (Sublayer 2b - Logical Access Control) ist für alle IEEE-802-LANs einheitlich. Sie bildet die logischen Anteile der Sicherungsschicht und sorgt für eine konsistente Schnittstelle zu den Netzwerkprotokollen der Schicht 3. Ihr Aufbau orientiert sich stark am HDLC-Protokoll (High Level Data Link Control), das als bitorientiertes Verfahren entwickelt wurde. Diese Schicht identifiziert, welches übergeordnete Protokoll (z. B. IPv4, IPv6 oder IPX) die Nutzdaten des Frames entgegennehmen soll.

Ab Schicht 4 sollen Unterschiede zwischen verschiedenen Netzwerktechniken nicht mehr erkennbar sein. Die Vereinheitlichung der LAN-Techniken unter IEEE 802 (z. B. Ethernet, WLAN) stellt sicher, dass ab Schicht 3 eine gemeinsame Schnittstelle bereitsteht, unabhängig von der jeweiligen Übertragungstechnik.

Network Layer (Vermittlungsschicht, Netzwerk Schicht, Routing Ebene)

Diese Schicht hat die Aufgabe, Netzverbindungen zwischen OSI-Systemen (Routing) herzustellen, d. h. Netzverbindungen zwischen Endsystemen mithilfe von gesicherten Teilstrecken aufzubauen. Die funktionalen und prozeduralen Mittel zur Übertragung von Vermittlungseinheiten (Pakete) zwischen Instanzen der Ebene 4 sind bereitzustellen. Funktionen von Transitsystemen arbeiten in den Schichten 1 bis 3, d. h. unterhalb der Transportschicht.

Transport Layer (Transportschicht, End-zu-End Ebene)

Diese Schicht hat die Aufgabe, einen gesicherten, transparenten Datentransfer zwischen Applikationen von Endteilnehmer zu Endteilnehmer (Datenquelle, Datensenke) für die höheren Schichten bereitzustellen. Die Transportschicht optimiert die Verwendung von Übertragungsressourcen.

Session Layer (Kommunikationssteuerungsschicht, Sitzungsschicht)

Diese Schicht hat die Aufgabe, Mittel zur Organisation und Synchronisation des Dialogs (Kommunikation) und die Verwaltung des Datenaustauschs bereitzustellen. So wird z. B. der Auf- und Abbau von Kommunikationsverbindungen (Sitzung) hier gesteuert.

Presentation Layer (Darstellungsschicht, Präsentationsebene)

Diese Schicht hat die Aufgabe, Informationen (Code) mithilfe derer die Anwendungsinstanzen kommunizieren, einheitlich (geräteunabhängig) darzustellen und Datenstrukturen festzulegen, auf die sich die Anwendungsinstanzen beziehen können.

Application Layer (Anwendungsschicht, Applikationsebene)

Diese Schicht hat die Aufgabe, Mittel zum Zugang zur OSI-Umgebung für Anwendungsprozesse bereitzustellen. Applikationen sind in Ebene 7 angesiedelt, d. h. Ebene 7 ist nach „oben offen“. Die Schnittstelle zur Applikation befindet sich demnach in Schicht 7

Transitsysteme sind Netzwerkknoten oder Zwischenstationen (z. B. Router oder Switches), die die Kommunikation zwischen zwei Endsystemen (Sender und Empfänger) weiterleiten und routen.

Sie sind nicht die Quelle oder das Ziel der Daten, sondern kümmern sich im OSI-Modell nur um die unteren Schichten (hauptsächlich Schicht 3/Netzwerkschicht) – also darum, wie das Datenpaket seinen Weg durch das Netz findet. Die höheren Schichten (ab Transport-Layer aufwärts) sind für diese Knoten unsichtbar.

3 Aufbau und Funktionsweise von Netzwerken

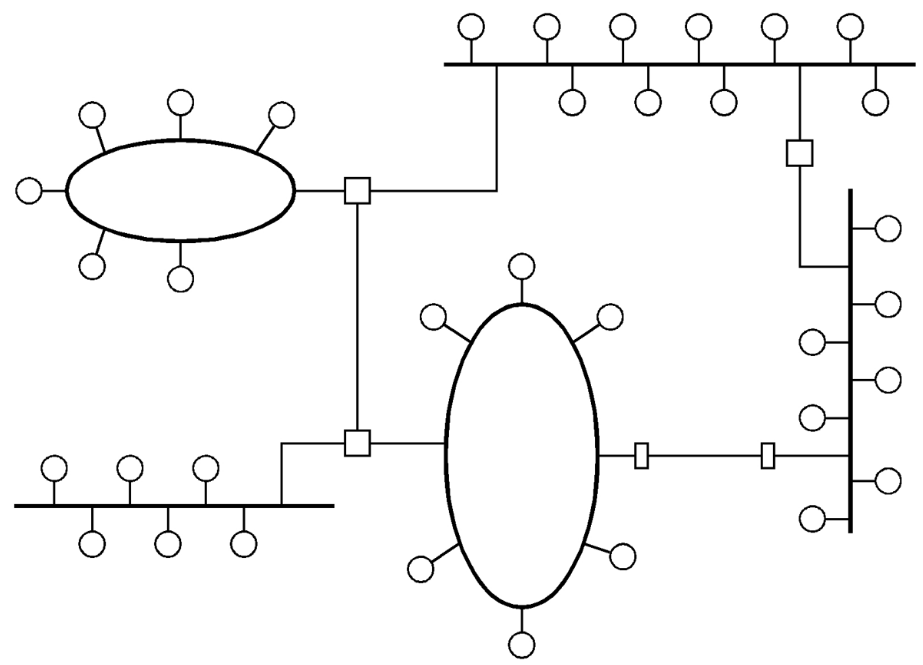

3.1 Topologien

Mit Topologie bezeichnet man die räumliche Anordnung von Netzelementen zueinander, oft auch in einem verallgemeinerten Sinn (logische Topologie). Die gebräuchlichsten Arten sind Bus, Ring, Stern und Baum.

Die physikalische Topologie beschreibt den Aufbau des Netzwerkes, d. h. die Form in der die Kabel verlegt sind. Die logische Topologie verweist auf den Pfad, den die Daten von der Quelle zum Ziel nehmen. Beide Formen können übereinstimmen (Ethernet), müssen es aber nicht (Token-Ring).

Moderne LANs nutzen häufig hierarchische, baumartige Verkabelungssysteme. Sie orientieren sich an der baulichen Umgebung und gliedern sich in drei Bereiche:

- Tertiärbereich für Arbeitsgruppen und Abteilungen, verbunden über Hubs oder Switches.

- Sekundärbereich: Grundlage ist ein gebäudeinternes Backbone, das die Gebäudeverteiler mit einzelnen Etagenverteilern auf Grundlage von Kupfer- oder Glasfaserkabeln verbindet.

- Primärbereich, Hierbei handelt es sich um eine gebäudeübergreifende Verkabelung mittels redundanter Kabeltrassen auf Lichtwellenleiterbasis, die an Gebäudeverteilern beginnen bzw. enden. Aufgrund der relativ großen Entfernungen kommen hierfür zurzeit ausschließlich Glasfaserkabel zum Einsatz.

Von dort erfolgt der Übergang über Gateways oder Firewalls zu externen Netzen.

Die klassische Netzsegmentierung stößt an ihre Grenzen, wenn der Datenverkehr innerhalb eines Segments zu hoch ist oder wenn zu viel Verkehr zwischen den Segmenten entsteht. Besonders durch Client/Server-Lösungen, Server-Parks und verteilte Systeme steigt die Belastung auf dem Backbone deutlich über das klassische 80:20-Verhältnis hinaus.

Switches dienen als Vermittlungseinheiten, die im Gegensatz zu Hubs mehrere Verbindungen gleichzeitig bereitstellen können. Für die angeschlossenen Stationen wirkt es, als hätten sie das Medium exklusiv für sich, wodurch die Bandbreite gezielt zugewiesen wird. Der Gesamtdurchsatz des Netzes wird nicht erhöht, aber die Effizienz der Zuweisung steigt.

Für Arbeitsplätze mit hohem Bandbreitenbedarf, etwa für Grafik- oder Videodaten, ist diese Optimierung meist ausreichend. Bei mehreren Stationen, die gleichzeitig mit demselben Server kommunizieren, ist der Gewinn begrenzt. Moderne Switches bieten hier höhere Bandbreiten an ausgewählten Anschlüssen und unterstützen die notwendigen Protokolle sowie unterschiedliche Geschwindigkeiten, um die Kommunikation effizient zu gestalten.

BUS

Das Busnetz nutzt ein passives Kabelmedium, das an den Enden mit einem Wellenwiderstand abgeschlossen ist, um schädliche Reflexionen zu unterbinden. Gesendete Daten breiten sich vom Sender nach beiden Seiten aus (Rundspruchmedium). Jede angeschlossene Station zapft das Medium an, ohne es zu unterbrechen.

Eine Unterbrechung des Kabels führt zu unkontrollierten Reflexionen und meist zum Ausfall des Netzes. Andererseits erlauben diese Reflexionen, über Laufzeitmessungen (TDR) den Ort des Kabelbruchs zu lokalisieren. Da Signale durch Dämpfung geschwächt werden, dienen Repeater der Signalwiederholung. Diese Verstärker dürfen nur zwischen Segmenten mit demselben Bitübertragungsprotokoll eingesetzt werden.

Ring

Ringnetze sind ebenfalls Rundspruchnetze in dem Sinne. Das heißt, der Datenverkehr wird von allen Stationen gehört. Üblicherweise wirkt jede Station als Verstärker, sie empfängt Signale von der Vorgängerstation und leitet sie an die nächste weiter. Implizit ist dadurch eine Richtung im Ring vorgegeben und man kann den Ring als geschlossene Folge von Punkt-zu-Punkt-Verbindungen auffassen.

Da jede Station beim Weiterleiten auch unvermeidlich etwas Verzögerung hinzufügt, ist die Zahl der Stationen begrenzt. Ansonsten wird die Ausdehnung des Ringes nur durch den Maximalabstand zweier Stationen eingeschränkt.

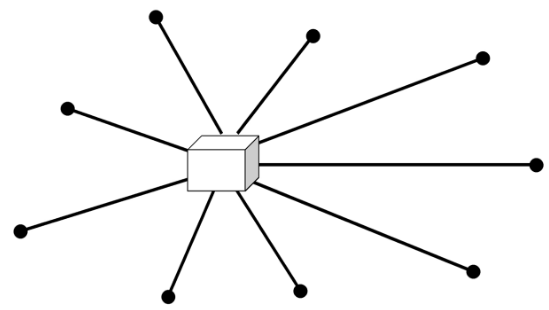

Stern

Die Stern-Architektur entspricht dem Schema der zentralisierten EDV, ist bei lokalen Netzwerken aber selten zu finden. Da LANs historisch aus der Verbindung autarker Stationen als Gegenbewegung zur Zentralisierung entstanden, lehnten Nutzer dieses Konzept zunächst ab. Als physikalisches Verkabelungsprinzip blieb der Stern jedoch dominant, besonders in den USA. Dies liegt an der Weiternutzung bestehender Telefonverkabelungen in Nebenstellennetzen für den Aufbau von LANs. Diese vorhandene Infrastruktur begünstigt moderne Lösungen. Durch den Einsatz intelligenter zentraler Verteilgeräte kann die sternförmige Verkabelung deutlich effizienter genutzt werden.

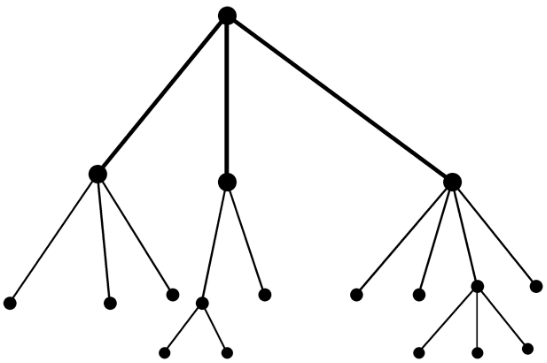

Baum

Diese Topologie ist in den Eigenschaften dem Bus ähnlich. Das Medium ist nicht linear angeordnet, sondern baumförmig verzweigt und für die Verteilung und Sammlung von Nachrichten von und zu einer Kopfstation gut geeignet. Die Baumtopologie ist fast nur in Breitbandsystemen zu finden, da dort Hin- und Rücksenden in zwei verschiedenen Frequenzbändern erfolgen kann. Die Kopfstation kann ein „dummer“ Frequenzumsetzer sein, welcher aber trotzdem ein kritischer Teil des Gesamtsystems ist.

3.2. Nahverkehrsnetze

Kommunikationsnetze können Ausdehnungen von wenigen Metern bis Tausende von Kilometern haben.

3.2.1. LAN

LAN (Local Area Networks) erstrecken sich maximal über einige Kilometer und ihre Übertragungsrate mehr als 1 MBit/s. Das Netz steht unter der Kontrolle und befindet sich auf dem Gelände einer Organisation.

Teilnetze ermöglichen durch die Zusammenfassung zu größeren Systemen oder die Aufteilung in logische Gruppen eine effiziente Lastverteilung.

Im Bereich der Kabelverbindungen hat Ethernet aufgrund seiner verschiedenen Geschwindigkeitsstufen und der Abwärtskompatibilität, die eine schrittweise Migration erlaubt, eine Monopolstellung erreicht.

Organisationsformen

Peer-to-Peer-Netze bestehen aus gleichberechtigten Stationen, die selbst entscheiden, welche Ressourcen sie freigeben. Sie eignen sich für kleine Gruppen, werden aber bei größeren Netzen schwer koordinierbar.

Serverorientierte Netze verwalten Ressourcen zentral über einen Server, der Dienste wie Datei- oder Druckservice bereitstellt und häufig mit speziellen Betriebssystemen arbeitet.

Da Kommunikationspartner in LANs häufig wechseln, wurde lange das Broadcast-Prinzip genutzt, bei dem alle Stationen eingehende Nachrichten empfangen. Dies erleichtert die Kommunikation, erfordert jedoch klare Regeln für Adressierung und Zugriff bei möglichen Kollisionen. Durch leistungsfähige und erschwingliche zentrale Geräte wie Switches wird zunehmend auf Broadcast-Verfahren verzichtet, um höhere Kapazitäten und effizientere Datenübertragung zu ermöglichen. Addressierung und Zugriffskontrolle müssen aber immer gegeben werden.

Client-Server-Architektur im LAN

Die Client-Server-Architektur im LAN beschreibt ein Netzwerkmodell, bei dem zentrale Server Dienste bereitstellen und die angeschlossenen Clients diese Dienste nutzen.

Server in lokalen Netzen bieten zentrale Dienste wie Datei-, Peripherie-, Datenbank- oder Applikationsdienste. Sie sollten leistungsfähige Maschinen mit schnellem Plattenzugriff und großem Arbeitsspeicher sein, da die Geschwindigkeit der Datenübertragung wichtiger ist als reine CPU-Leistung. Gehäusegröße, Wartungsfreundlichkeit, zuverlässige Stromversorgung und Schutz vor Fehlbedienungen sind entscheidend. Gut ausgelegte Server und Netzwerke ermöglichen Datenzugriff oft schneller als von lokalen Festplatten.

Dateiserver

Dateiserver (File Server) sind die klassische Form zentraler Speicherbereitstellung im LAN. Sie erlauben Clients den Zugriff auf Dateien, Verzeichnisse und ganze Laufwerke.

Direkt angeschlossene Massenspeicher an den Server bezeichnet man als Direct Attached Storage (DAS). Später kamen Network Attached Storage (NAS) hinzu, bei dem die Speicher über eigene Netzwerkschnittstellen und spezialisierte Dateiverwaltung verfügen. NAS-Systeme sind meist Mini-Linux-Systeme, leicht erweiterbar und über Webschnittstellen administrierbar, stoßen jedoch bei sehr hohem Datenverkehr an die Grenzen der Netzwerkanbindung, da die Protokollebene der Dateiübertragung zusätzlichen Aufwand erzeugt.

DAS vs NAS Direct Attached Storage (DAS) ist direkt an einen Server angeschlossen, meist über interne Schnittstellen wie SATA, SAS oder SCSI. Der Speicher ist ausschließlich über diesen Server zugänglich, der Server übernimmt die gesamte Verwaltung der Daten. DAS ist sehr schnell, da keine Netzwerkprotokolle den Zugriff bremsen, eignet sich aber schlecht, wenn mehrere Server gleichzeitig auf denselben Speicher zugreifen sollen.

Network Attached Storage (NAS) dagegen ist ein eigenständiges Gerät mit eigener Netzwerkschnittstelle und eigener Dateiverwaltung. Clients greifen über das Netzwerk auf NAS-Systeme zu, meist per TCP/IP und Dateifreigabeprotokollen wie SMB/CIFS oder NFS. NAS kann von mehreren Clients gleichzeitig genutzt werden und ist leicht administrierbar, weil die Dateiverwaltung im Gerät selbst liegt. Die Geschwindigkeit hängt jedoch von der Netzwerkanbindung ab und ist bei sehr hohem Datenaufkommen oft niedriger als bei DAS.

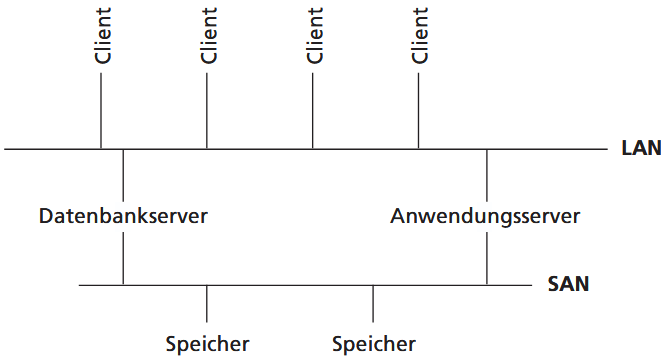

Eine leistungsfähigere Variante sind Storage Area Networks (SAN), bei denen ein dediziertes Hochgeschwindigkeitsnetz zwischen Servern und Speichersystemen eingerichtet wird. Der Zugriff erfolgt auf hardwarenaher Ebene, oft über Glasfaserlösungen wie Fibre Channel oder über iSCSI, das SCSI-Befehle über IP-Netzwerke transportiert. SAN-Systeme entkoppeln das Speichernetz vom normalen LAN, sodass beispielsweise Backup-Vorgänge die Übertragungsleistung im LAN kaum beeinträchtigen.

Peripherieserver

Peripherieserver stellen im LAN speziellen Geräten wie Druckern oder Faxgeräten den Zugriff für mehrere Nutzer bereit. Sie übernehmen Aufgaben wie das Zwischenspeichern von Druckaufträgen (Spooling) und administrative Funktionen, sodass die Peripheriegeräte effizient gemeinsam genutzt werden können. Manche Geräte, z. B. moderne Netzwerkdrucker oder Multifunktionsgeräte, besitzen bereits eigene Netzwerkfähigkeiten und Serverfunktionen (firmware), sodass sie direkt ans Netz angeschlossen werden können. Auch Router oder Koppelhardware bieten oft integrierte Funktionen, um Peripheriegeräte über das Netzwerk verfügbar zu machen.

Datenbankserver

Datenbankserver sind spezialisierte Server, die große Mengen an Daten speichern und effizienten Zugriff darauf ermöglichen. Anders als bei herkömmlichen Dateiservern werden nicht komplette Dateien über das Netzwerk übertragen, sondern nur die relevanten Abfrageergebnisse, nachdem die Serversoftware Vorabauswertungen oder Filterungen vorgenommen hat. Wichtig ist die Transaktionssicherheit: Alle zusammengehörigen Operationen müssen vollständig ausgeführt werden, oder es muss im Fehlerfall ein definierter Zustand wiederhergestellt werden können (Roll-back). Datenbankserver unterstützen gleichzeitig viele Clients, sichern Schreibzugriffe auf dieselben Datensätze ab (Record Lock) und skalieren bei Bedarf auf hohe Zugriffszahlen. Früher waren solche Systeme auf Großrechner beschränkt, heute sind auch verteilte Lösungen im Netzwerk üblich, oft in Verbindung mit SANs für schnellen Speicherzugriff.

Server für Internet- und Intranetdienste

Mailserver bilden eine der zentralen Säulen für die Kommunikation in LANs und über das Internet. Sie empfangen Nachrichten von Clients oder anderen Mailservern, speichern sie bei vorübergehender Nicht-Erreichbarkeit der Zieladresse und stellen sie anschließend zu. Dabei nutzen sie standardisierte Protokolle wie SMTP, POP3 oder IMAP.

WWW-Server oder Webserver sind für die Bereitstellung von Webseiten zuständig. Intern dienen sie der Organisation von Informationen über Intranet-Lösungen, extern ermöglichen sie Kundenkontakt, Öffentlichkeitsarbeit und Online-Dienste wie Bestellungen oder Informationsbereitstellung. WWW-Server müssen kontinuierlich erreichbar sein, was für kleinere Organisationen oft bedeutet, dass der Server bei einem externen Provider gehostet wird. Ein Schwerpunkt liegt auf Sicherheit, da manipulierte Seiten erheblichen Schaden anrichten können. Deshalb werden Webserver häufig in sogenannten Demilitarized Zones (DMZ) betrieben, die von internen und externen Netzen gut erreichbar, aber gleichzeitig gut abgeschirmt sind.

FTP-Server dienen traditionell dazu, Dateien für Clients zum Herunterladen bereitzustellen. Während früher speziell eingerichtete Server notwendig waren, ist diese Funktion heute oft in Webseiten integriert und für den Nutzer praktisch unsichtbar. FTP-Server sind besonders bei hohem Datenaufkommen oder bei der Bereitstellung großer Softwarepakete relevant, z. B. für Updates, Patches oder Treiber.

Insgesamt ermöglichen diese unterschiedlichen Serverdienste, dass viele Nutzer gleichzeitig auf Daten, Anwendungen oder Informationen zugreifen können, ohne dass es zu Engpässen oder Konflikten kommt. Dabei ist die Kombination aus permanenter Verfügbarkeit, Datensicherheit und Benutzerfreundlichkeit entscheidend für einen stabilen und effektiven Betrieb.

3.2.1.1 Zugriffsmechanismen

Erst ein geeignetes Steuerungsverfahren für den LAN-Zugang, also die Festlegung, wer wann welche Daten senden oder empfangen darf, macht die LANs auch benutzbar.

Eine Vorschrift, die den gemeinsamen, geordneten Zugriff auf das wechselseitig ausschließlich zu benutzende Übertragungsmedium regelt, heißt Zugriffsmechanismus.

Es gibt die beiden grundsätzlichen Verfahren:

- wahlfreier Zugriff mit Kollisionsüberwachung und

- kontrollierter Zugriff durch Weitergabe einer ausschließlichen Sendeberechtigung.

Die Zugriffsmechanismen auf das Übertragungsmedium sind im Prinzip von der Netztopologie unabhängig. In der Praxis wird aber der wahlfreie Zugriff nur bei Busnetzen verwendet.

Kollisionsüberwachung

Bei einem gemeinsamen Übertragungskanal können alle Stationen jederzeit senden. Treffen jedoch mehrere Nachrichten gleichzeitig ein, erhält der Empfänger nur eine beschädigte Nachricht und bestätigt sie nicht. Dadurch erkennen die Sender, dass ihre Übertragung fehlgeschlagen ist und sie erneut senden müssen. Beim reinen ALOHA Verfahren senden Stationen nach einem zufällig gewählten Zeitintervall erneut, um erneute Kollisionen zu vermeiden. Dieses einfache Verfahren erreicht eine maximale Kanalausnutzung von nur etwa 18 %. Eine Verbesserung bietet slotted ALOHA, bei dem nur zu Beginn definierter Zeitschlitze gesendet werden darf. Dadurch steigt die maximale Ausnutzung auf etwa 37 %.

Eine weitere Effizienzsteigerung ergibt sich, wenn Sender das Medium vor dem Senden überwachen. Beim CSMA (Carrier Sense Multiple Access) prüft eine Station, ob der Kanal frei ist, und wartet gegebenenfalls. Varianten wie non-persistent CSMA oder die p-persistent Methode reduzieren die Wahrscheinlichkeit gleichzeitiger Sendeversuche nach dem Freiwerden des Mediums.

Bei CSMA/CD (CD =collision detection) wird das Medium zusätzlich während des Sendens überwacht. Tritt eine Kollision auf, bricht die Station sofort ab und sendet ein JAM-Signal, das alle Stationen informiert. Anschließend versuchen die Sender nach einem algorithmisch festgelegten, häufig verlängerten Warteintervall erneut zu senden. Nach zu vielen Fehlversuchen wird der Vorgang abgebrochen und der Anwendung ein Fehler gemeldet.

Hohe Datenraten und physikalische Signalgeschwindigkeiten führen dazu, dass Kollisionen erst erkannt werden, nachdem bereits viele Bits übertragen wurden. Dies begrenzt die maximale Ausdehnung von CSMA/CD-basierten LANs. Mindestlängen für Datenrahmen und die Verzögerungen durch Zwischenstationen wie Repeater müssen deshalb beachtet werden, um Kollisionen sicher erkennen zu können.

Kontrollierter Zugriff

Kontrollierte Zugriffsverfahren reservieren einen Teil der Kanalkapazität, um den Zugriff auf das Medium zu steuern. Statt dass Stationen in Konkurrenz gleichzeitig versuchen zu senden, wird der Zugriff im Voraus organisiert, etwa durch Reservierungsphasen, in denen sendewillige Stationen nach festgelegten Regeln ihre Sendeberechtigung bestimmen.

Beim Token-Passing wird ein spezielles Bitmuster, das sogenannte Token, im Netz zyklisch von Station zu Station weitergereicht. Nur die Station, die das Token besitzt, darf senden. Sie entnimmt das Token, führt ihre Übertragung aus und gibt es anschließend wieder weiter. Währenddessen können andere Stationen nicht senden, da sie das Token nicht besitzen.

Diese Methode gewährleistet eine hohe Effizienz bei starker Netzbelastung, da keine Kollisionen auftreten und die verfügbare Kapazität optimal genutzt wird. Bei geringer Last entstehen jedoch systematische Wartezeiten, da jede Station darauf angewiesen ist, dass das Token bei ihr vorbeikommt, selbst wenn keine andere Station senden möchte. Je größer das Netz, desto länger wird diese durchschnittliche Wartezeit.

Token Ring

Der Token Ring ist ein Beispiel für kontrollierten Medienzugriff. Er wurde von IBM für PC-Netze entwickelt und arbeitete mit 1 oder 4 Mbit/s, später mit 16 Mbit/s. Als Übertragungsmedium kam verdrilltes Doppelkabel zum Einsatz, die Signale wurden mithilfe der differenziellen Manchester-Codierung erzeugt. Obwohl der Token Ring logisch als Ring strukturiert ist, erfolgt die Verkabelung physikalisch sternförmig über ein zentrales Verkabelungszentrum. Dieses enthält Umschalter, die bei einem Ausfall einzelne Stationen vom aktiven Ring abkoppeln und den Datenfluss über einen inneren passiven Ring weiterführen.

Das zentrale Kontrollelement des Token Rings ist das Token, ein Bitmuster, das die Sendeberechtigung eindeutig regelt. Es zirkuliert kontinuierlich im Ring und muss spätestens nach der sogenannten token holding time weitergegeben werden. Erhält eine sendewillige Station das Token, so behält sie es, sendet ihre Daten und gibt es erst danach weiter. Die übertragenen Bits laufen einmal vollständig um den Ring und werden vom Absender wieder entfernt. Die Verzögerungen, die durch das Empfangen und erneute Weiterleiten in jeder Station entstehen, tragen meist stärker zur Umlaufzeit bei als die eigentliche Leitungslänge.

Ein häufig betonter Vorteil war die Robustheit gegenüber Überlast, da im Unterschied zum klassischen Ethernet keine Kollisionen auftreten können. In der Praxis zeigte sich jedoch, dass Netzwerke lange vor einem theoretischen Zusammenbruch so langsam werden, dass ohnehin Maßnahmen zur Kapazitätserhöhung nötig sind. Mit der Einführung von Fast- und später Gigabit-Ethernet verlor zudem der Geschwindigkeitsvorteil des Token Rings seine Relevanz.

3.2.1.2 Im LAN genutzte Techniken

Ethernet

Nach der Wahl des physischen Verbindungstyps stellt sich die Frage, wie Rechner überhaupt auf das Übertragungsmedium zugreifen. Es gibt zwei Grundprinzipien: Beim wahlfreien Zugriff handeln alle Stationen selbstständig und belegen das Medium sofort, wenn sie senden wollen. Eine zentrale Steuerung ist nicht nötig, weshalb Ethernet dieses Verfahren nutzt. Beim verteilt gesteuerten Zugriff dagegen dürfen Geräte erst senden, wenn sie zuvor eine Berechtigung erhalten haben, was ein eigenes Vergabemanagement erfordert.

Zusätzlich muss festgelegt werden, in welcher Richtung die Kommunikation abläuft. Simplex bedeutet, dass Daten ausschließlich in eine Richtung fließen, wie beim Rundfunk. Halbduplex lässt zwar Senden und Empfangen zu, jedoch nicht gleichzeitig, vergleichbar mit einer einspurigen Straße mit Ampelregelung. Vollduplex erlaubt gleichzeitiges Senden und Empfangen und ist deshalb heute die typische Betriebsart in Netzwerken, da Geräte während der eigenen Übertragung jederzeit Kontrollinformationen empfangen können müssen. Während Ethernet ursprünglich nur Halbduplex standardisiert hatte, hat sich Vollduplex inzwischen vollständig durchgesetzt und ist heute der Normalfall.

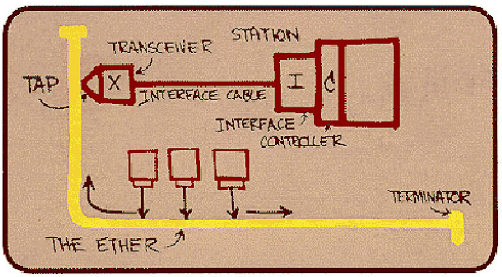

Ethernet wurde in den 1970ern von Xerox, Intel und DEC entwickelt und später in ISO 8802-3 bzw. IEEE 802.3 standardisiert. Das ursprüngliche Ethernet arbeitete mit 10 Mbit/s und nutzte ein Basisbandverfahren ohne Trägerfrequenzen.

Die Wurzeln des Ethernets liegen in Hawaii. Die dortige Universität baute Anfang

der 70iger Jahre ein Funknetz auf, um für die Inselgruppe eine Kommunikationsplatt-

form zu schaffen. Robert Metcalfe, damals noch Student und späterer Gründer der

Firma 3Com, verfeinerte das einfache Verfahren und prägte in Anlehnung an die

ursprüngliche Übertragung via Äther den Namen Ethernet. Am 22.5.1973, so die

Legende, notierte Metcalfe erstmals den Begriff Ethernet in einem Entwurf. Die kom-

plexe Architektur des Ausgangsentwurfs spiegelt die folgende Abbildung wider:

Ethernet-Varianten tragen Bezeichnungen wie 10Base2 oder 100BaseTX. Die Zahl benennt die Datenrate, Base das Basisbandverfahren, der Buchstabe oder die Zahl das physikalische Medium. Die Endziffern 2 und 5 stehen für maximale Segmentlängen in Hundert Metern, T für Twisted Pair, F für Glasfaser.

Zu den frühen Varianten gehörten 10Base5 (Thick Ethernet) mit dickem gelbem Koaxialkabel und 10Base2 (Thin Ethernet) mit dünnerem Koax. Später dominierte 10BaseT, das Twisted-Pair-Leiterpaare und sternförmige Verkabelung über Hubs nutzt, die logisch dennoch einem Bus entsprechen.

Twisted Pair setzte sich durch, da Hubs und Netzwerkkarten günstig wurden und die Installation einfacher war. Der Übergang zu schnelleren Techniken wie Fast Ethernet verlief dadurch unkompliziert. Hubs erkennen Kollisionen direkt an ihren Ports und senden sofort JAM-Signale, unabhängig von Kabellängen. Da bei Twisted Pair zwei Leitungspaare genutzt werden, können zwei direkt verbundene Geräte im Full-Duplex-Modus senden, wodurch Kollisionen entfallen und die nutzbare Bandbreite steigt. Mit Switches wird dieser Vorteil vollständig ausgenutzt.

Ethernet nutzt die Manchester-Codierung, bei der jedes Bit durch einen Signalwechsel in der Mitte der Bitperiode dargestellt wird. So werden Daten und Takt gleichzeitig übertragen, was die Synchronisation zwischen Sender und Empfänger erleichtert.

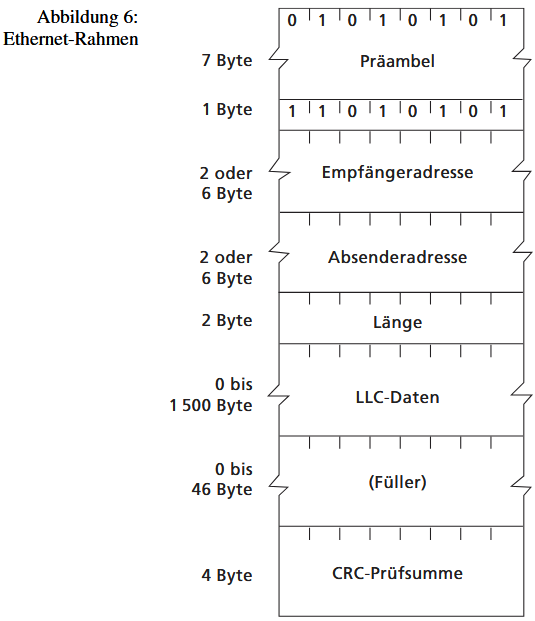

Ein Ethernet-Rahmen besteht aus Präambel (7 Byte) zur Synchronisation, Rahmenstart-Byte, Empfänger- und Absenderadresse (jeweils 6 Byte), 2 Byte für die Länge des LLC-Datenfeldes (Logical Link Control), dem LLC-Datenfeld selbst und einer 32-Bit-CRC-Prüfsumme. Kurze Datenfelder werden mit Füllbytes auf mindestens 64 Byte aufgefüllt, um Kollisionen zuverlässig erkennen zu können.

Erkennt ein Sender eine Kollision, werden zusätzlich 32 Bits gesendet, damit alle Stationen die Kollision wahrnehmen (JAM-Signal). Die Erkennung erfolgt analog über Signalamplituden, weshalb Kabelqualität und Dämpfung für die Netzplanung entscheidend sind. Die Mindestlänge des Rahmens definiert außerdem die Slotzeit für die CSMA/CD-Algorithmen.

Zugriffsverfahren CSMA/CD (Carrier Sens Multiple Access with Collision Detection)

Ethernet nutzt als Zugriffsmethode das wahlfreie CSMA/CD-Verfahren, das davon ausgeht, dass alle Rechner denselben fairen Zugang zum Medium haben, welches als gemeinsame Ressource dient. Jeder gesendete Frame breitet sich im gesamten Netz aus und wird von allen Stationen geprüft; nur die Station mit passender Zieladresse übernimmt ihn, alle anderen verwerfen ihn – die Kommunikation folgt also einem Broadcastprinzip.

Das Verfahren gliedert sich in drei Grundideen: Zunächst wird das Medium ständig auf Aktivität überwacht (Carrier Sense), anschließend teilen sich alle Stationen das Medium gleichberechtigt (Multiple Access), und im Fall gleichzeitiger Sendebeginne werden Kollisionen erkannt (Collision Detection).

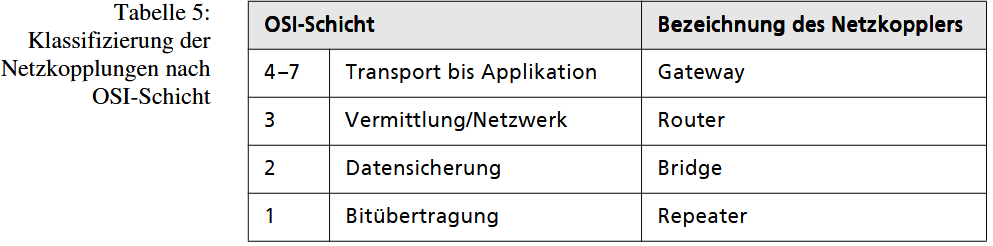

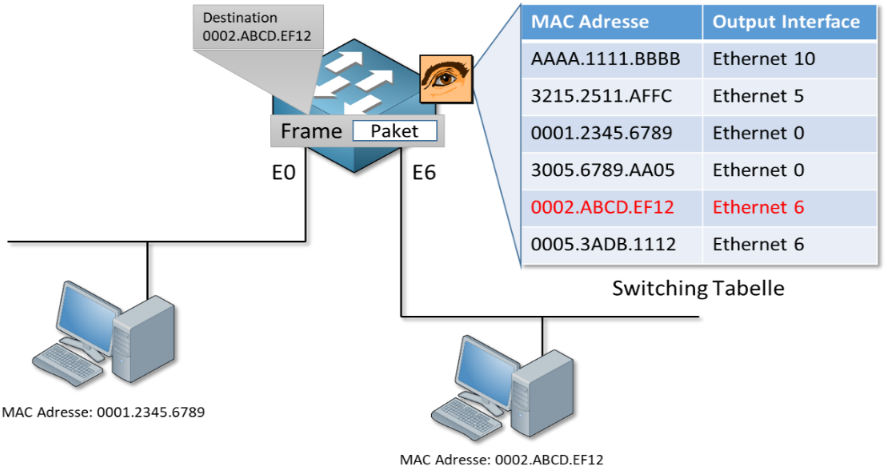

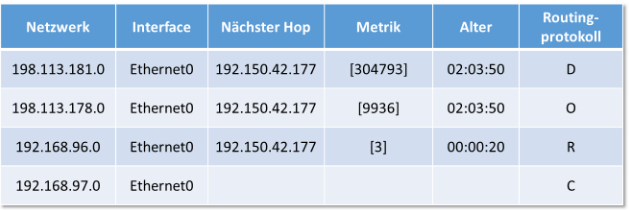

Der praktische Ablauf ähnelt einem Gruppengespräch: Eine Station sendet erst, wenn das Medium für die Dauer der Interframe Gap – einer kurzen Ruhephase von 96 Bitzeiten – frei bleibt, um zu verhindern, dass eine einzelne Station dauerhaft das Medium monopolisiert. Während des Sendens wird das Medium weiterhin überwacht, um Kollisionen sofort zu erkennen. Bleibt die Übertragung kollisionsfrei, gilt der Frame als erfolgreich gesendet. Die Interframe Gap sorgt außerdem dafür, dass kein rein linearer Zusammenhang zwischen Paketgröße und möglicher Paketanzahl entsteht, da zwischen zwei Frames immer ein verpflichtender zeitlicher Abstand liegt.